挑战GPT-4o!阿里开源Qwen-Image-Edit模型,在中文图像渲染与编辑上取得突破

文章来源:智汇AI 发布时间:2025-08-21

阿里通义千问团队重磅开源全新图像编辑模型 Qwen-Image-Edit,在图像生成与编辑领域再掀波澜。该模型中英文双语精准渲染,中文表现尤为突出,还具备双重编码机制、多任务训练等优势,应用场景广泛…

暂无访问近日,阿里通义千问团队又有大动作,正式开源了全新图像编辑模型Qwen-Image-Edit。这不仅是通义千问系列在图像生成与编辑领域的又一重要成果,更在多个方面展现出卓越性能,有望重塑行业格局。

Qwen-Image-Edit模型的优势1.中英文双语精准渲染,中文表现一骑绝尘

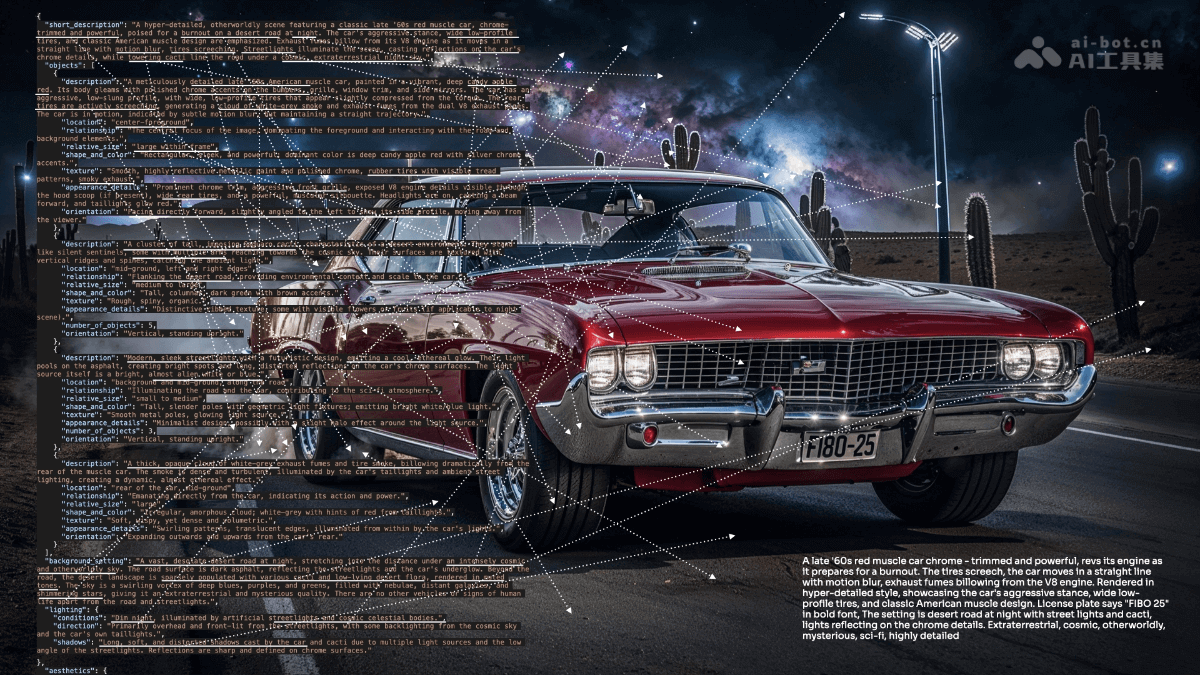

Qwen-Image-Edit继承并升级了文本渲染能力,无论是英文还是中文,都能实现高保真编辑。它支持直接在图像中添加、删除或修改文本,同时完美保留原有字体、大小和风格。在中文场景下,优势尤为突出。处理多行布局、段落级文本生成以及书法对联等复杂排版需求都不在话下,单字渲染准确率高达97.29%,远超Seedream3.0(53.48%)和GPTImage1(68.37%)。

比如,将海报上的“Hope”替换为“Qwen”,或者在书法作品中修正错误字符,它都能轻松完成,还能保持图像整体视觉一致。这一能力对广告设计、品牌宣传和内容创作行业来说,无疑是一大助力。

2.双重编码机制,语义外观双控

Qwen-Image-Edit的核心技术创新在于双重编码机制。在图像编辑时,输入图像会同时经过Qwen2.5-VL模型进行语义编码,提取高层场景和对象关系特征;还会通过变分自编码器(VAE)进行重建编码,保留底层视觉细节,如纹理和颜色。

这种机制让模型在执行复杂编辑指令时,既能理解语义意图,又能保持视觉保真度。语义编辑中,能将人物姿态调整为“弯腰牵狗爪”,同时保持人物身份和背景一致;外观编辑时,可精确添加带有真实反射的标牌或移除细微头发丝,其他区域不受影响。在IP创作、风格迁移和新视角合成等场景中表现出色。

3.多任务训练,编辑一致性行业领先

通过增强的多任务训练范式,Qwen-Image-Edit支持文本到图像(T2I)、图像到图像(I2I)以及文本引导图像编辑(TI2I)等多种任务。在GEdit、ImgEdit和GSO等图像编辑基准测试中,它均取得SOTA性能,综合评分分别达到7.56(英文)、7.52(中文),超越GPTImage1和FLUX.1Kontext等竞争对手。

值得一提的是其“链式编辑”能力。在书法纠错场景中,模型能通过多轮迭代逐步修正错误字符,同时保持整体风格一致,大幅提升了创作效率,降低了专业视觉内容创作的门槛。

开源赋能,推动全球AI创作生态

Qwen-Image-Edit基于Apache2.0协议完全开源,用户可通过HuggingFace、ModelScope等平台免费获取模型权重,还能通过QwenChat的“ImageEditing”功能在线体验。阿里在ComfyUI中提供原生支持,并发布详细技术报告和快速上手指南,方便开发者快速集成。

社交媒体上,开发者反响热烈,称其“将中文渲染和图像编辑能力拉到商用水准”,效果“媲美甚至超越GPT-4o和FLUX.1”。此外,模型支持多种LoRA模型,进一步扩展了在高真实感图像生成中的应用场景。

体验地址:QwenChat网页版官网入口

登陆QwenChat官网首页--点击左上角QwenChat---现在开始--点击图片编辑即可

应用场景广泛,适合多行业

Qwen-Image-Edit的多功能特性使其适用于多种场景。在海报与广告设计领域,能生成具有视觉冲击力的宣传海报,支持复杂文本排版和风格迁移;IP内容创作中,可基于品牌吉祥物生成主题表情包,保持角色一致性;教育与培训方面,能快速生成高质量插图和图表,提升课程内容吸引力;游戏与影视行业,可支持角色设计、背景生成和新视角合成,优化资产开发流程。

用户反馈显示,其直观操作和高质量输出是非专业设计者的理想工具。一位内容创作者表示:“Qwen-Image-Edit让我在几分钟内完成营销视觉设计,文本渲染精准,效果堪比专业软件。”

阿里通义千问团队的Qwen-Image-Edit,凭借强大的文本编辑能力、双重编码机制和开源特性,为AI图像生成与编辑领域树立了新标杆。无论是中文渲染的领先,还是语义与外观编辑的平衡,都展现出其作为行业顶尖模型的实力。