腾讯发布开源大模型“混元-A13B”,革新动态推理能力,让AI更懂思考

文章来源:智汇AI 发布时间:2025-07-07

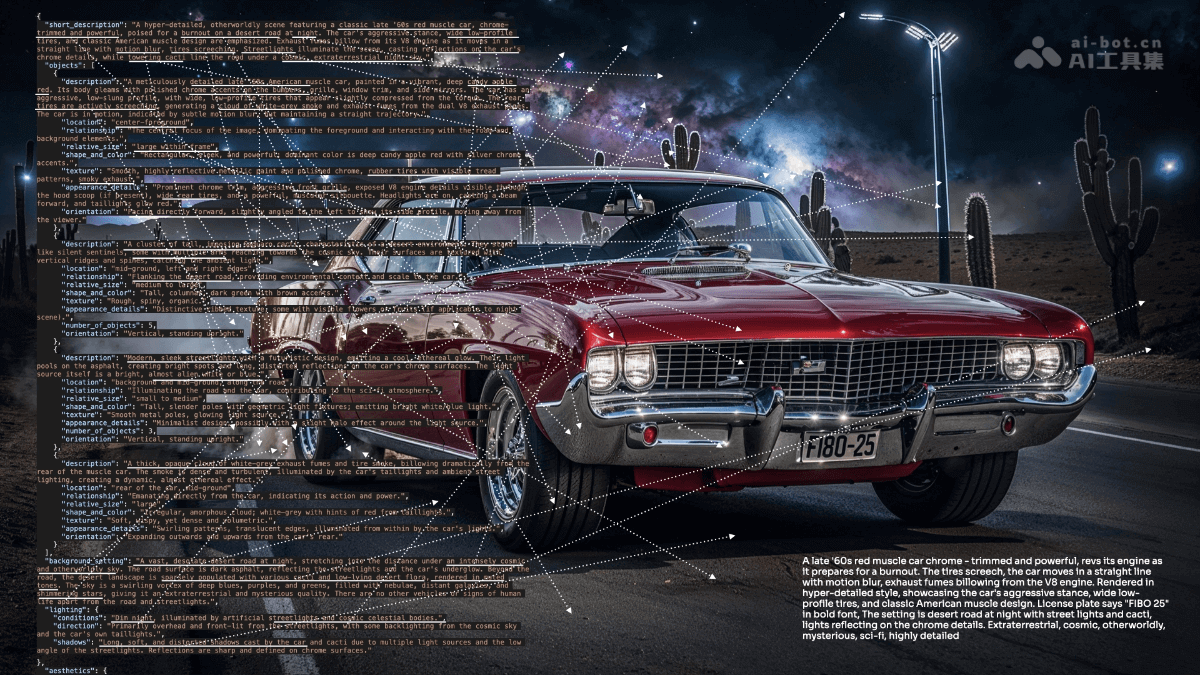

在人工智能语言模型竞争白热化的当下,腾讯宣布开源全新语言模型“混元 - A13B”,引发科技圈高度关注。它具备实时调整推理深度的能力,采用独特的MoE架构,在海量数据训练下性能出众。虽与顶尖模型竞技…

暂无访问在人工智能发展一日千里的当下,语言模型领域已成为科技巨头们激烈角逐的战场。各大企业纷纷投入海量资源,试图在这片充满无限可能的领域中拔得头筹。

近日,腾讯宣布开源其全新语言模型“混元-A13B”,这一消息如同一颗投入平静湖面的巨石,在科技圈激起了层层涟漪,引发了广泛关注。它凭借创新的动态推理方法和诸多独特优势,为语言模型的发展开辟了新的道路,注入了新的活力。

腾讯混元-A13B的核心功能

当你向它询问一些简单直接的问题,例如“明天的天气如何”,它会迅速启用快速模式,以最少的推理步骤,在极短的时间内给出答案,让你无需漫长等待。而当你提出一些复杂且需要深入分析的问题,像“如何制定一套全面且有效的城市交通拥堵解决方案”,它则会激活多步骤思考的深度推理过程,从交通流量、道路规划、公共交通系统等多个方面进行全面、深入的分析,为你提供详尽且具有可操作性的解答。

此外,用户还可以通过特定命令来手动控制模型的行为。使用“/think”就能启用深度模式,让模型进行更深入、细致的思考;使用“/no_think”则可关闭深度模式,使模型快速给出答案。这种灵活的控制方式,极大地满足了不同用户在不同场景下的多样化需求。

腾讯混元-A13B的架构解析:

“混元-A13B”采用的混合专家(MoE)架构是其一大亮点。该模型的总参数量高达800亿,但在实际推理过程中,仅有130亿个参数处于活跃状态。

这种独特的设计就如同一个高效的团队。在一个大型项目中,团队里有众多成员,但并非所有成员在每个阶段都需要同时参与工作。只有那些在特定任务中具有专业知识和技能的成员才会被激活,发挥自己的专长。

在“混元-A13B”中也是如此,不同的参数就像团队中的不同成员,根据任务的需求,只有相关的参数会被激活参与推理过程。这样既保证了模型在处理各种复杂任务时能够展现出强大的性能,又提高了运行效率,大大降低了计算资源的消耗,使得模型在资源有限的情况下也能高效运行。

混元-A13B的数据支撑:海量训练铸就知识宝库

一个优秀的语言模型离不开大量高质量训练数据的支持。“混元-A13B”在20万亿个token的数据上进行了训练,并且针对推理任务及更广泛的用例进行了优化。

为了提升模型在科学任务中的可靠性,腾讯还特别从STEM(科学、技术、工程、数学)领域收集了2500亿个token进行训练。这些数据来源广泛,涵盖了数学教科书、各类考试题目、GitHub上的开源代码、逻辑谜题以及从小学到大学的科学文本等。

丰富的数据来源为模型提供了海量的知识储备,就像为模型建造了一个巨大的知识宝库。模型在经过大量数据的训练后,能够更好地理解和处理各种类型的问题,无论是在日常对话、学术研究还是专业领域的应用中,都能展现出出色的性能。

性能较量:与顶尖模型的同台竞技

在性能表现方面,腾讯声称其“混元-A13B-Instruct”版本能够与OpenAI、Deepseek和阿里巴巴Qwen等领先模型相媲美。在2024年美国数学竞赛AIME中,“混元-A13B”取得了87.3%的准确率,领先于OpenAIo1的74.3%,这一成绩充分展示了它在数学推理方面的强大能力。

然而,我们也应该以客观、理性的态度看待这些数据。从2025年的结果来看,OpenAIo1在该轮测试中领先近3%。而且,腾讯的比较数据基于Deepseek-R1的过时1月版本,而Deepseek在5月发布的版本在AIME2024和2025中的表现更优异,分别取得了91.4分和87.5分。这说明在语言模型领域,竞争异常激烈,各模型都在不断进步和优化。每个模型都有其独特的优势和不足,它们在不同的场景和任务中可能会表现出不同的性能。

腾讯开源“混元-A13B”,为开发者提供了一个强大的工具,也为语言模型的研究和发展注入了新的活力。它的动态推理和MoE架构等创新设计,为未来的语言模型发展提供了有益的借鉴。相信随着技术的不断进步和应用的不断拓展,“混元-A13B”将在更多领域发挥重要作用,为我们带来更多的惊喜和便利,推动语言智能迈向一个新的高度。

混元-A13B模型地址

模型地址:https://modelscope.cn/models/Tencent-Hunyuan/Hunyuan-A13B-Instruct/summary

github地址:https://github.com/Tencent-Hunyuan/Hunyuan-A13B

腾讯混元大模型地址:立即体验