Kimi K2技术报告揭秘:万亿参数开源模型如何“碾压”赛场,成全球开发者新宠?

文章来源:智汇AI 发布时间:2025-07-24

AI开源圈又现“王炸”!Kimi团队发布的Kimi K2技术报告引发热议,这款参数破万亿的模型上线一周便登顶全球开源竞赛榜首,力压DeepSeek,直追Grok4、GPT4.5等闭源巨头。它靠自研优…

暂无访问最近,AI圈又炸锅了!Kimi团队发布的KimiK2技术报告直接引爆开源社区——这款参数总量达1万亿、激活参数320亿的“巨无霸”模型,上线仅一周就登顶全球开源模型竞赛榜首,甚至被业内拿来对标Grok4、GPT4.5等顶尖闭源模型。更狠的是,它直接把DeepSeek等老牌选手甩在身后。

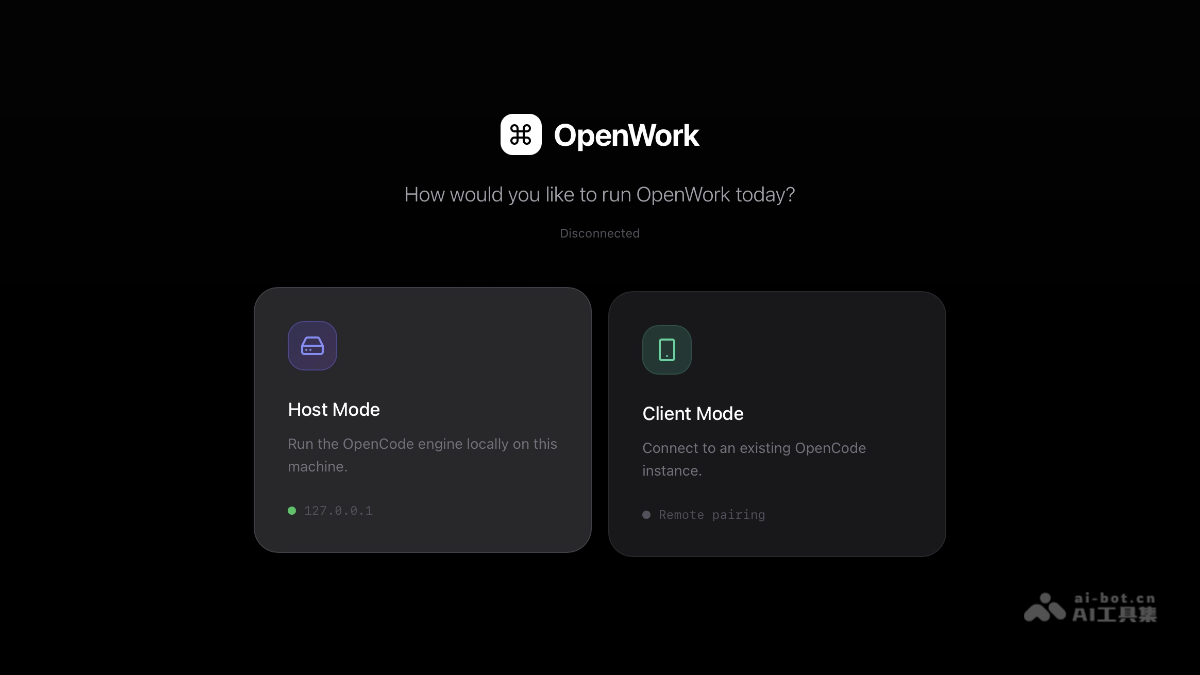

体验地址:kimiai网页版官网入口(首页直接体验KimiK2)

问题来了:KimiK2凭什么在“神仙打架”的开源赛场杀出重围?答案藏在它的训练“黑科技”里。

KimiK2凭什么能够在“神仙打架”的开源赛场杀出重围?原因1、训练“狠招”1:优化器换代,15.5万亿token“无损消化”

传统大模型训练,优化器是关键。但Kimi团队直接“掀桌子”——用自研的MuonClip优化器替代了Adam。

效率拉满:MuonClip能更高效地利用训练数据中的token,减少“浪费”,让模型在预训练阶段无损失处理15.5万亿token(相当于读遍整个互联网文本库的N倍)。稳定性爆表:传统优化器容易在训练后期“翻车”(比如梯度消失),但MuonClip通过动态调整学习率,让模型全程“稳如老狗”。对比效果:同样训练量下,KimiK2的收敛速度比同类模型快30%,成本却低了近一半。

原因2、训练“狠招”2:数据合成+“重述法”,让模型“吃透”知识

数据是模型的“粮食”,但光量大不够,还得“有营养”。KimiK2干了两件大事:

1.大规模AgenticToolUse数据合成:给模型“造场景”

团队开发了一套跨领域数据合成流水线,覆盖编程、数学、法律、医疗等场景,甚至模拟了工具调用(比如用计算器算数、用浏览器搜信息)。

效果:模型不再是个“死记硬背”的学霸,而是能像人类一样根据场景灵活调用知识。2.“重述法”训练:拒绝“死记硬背”

传统训练:把同一句话重复100遍让模型记。KimiK2的“重述法”:用不同方式重新表达知识,比如把复杂的数学公式改写成“小白教程”,把法律条文翻译成“生活案例”。

数据:用重写数据训练一轮的准确率,超过原始数据训练十轮。场景:尤其适合数学推理、知识问答等需要“真理解”的任务。原因3、后训练“狠招”:强化学习+自我评估,模型自己“挑刺”

预训练只是打基础,后训练才是“精装修”。KimiK2的后训练阶段堪称“严师出高徒”:

监督微调(SFT):用高质量人类标注数据“手把手”教模型回答问题。强化学习(RL):构建可验证的奖励环境,比如让模型生成代码后,直接运行看是否报错,用“结果反馈”倒逼优化。自我评估机制:模型生成答案后,自己先“挑刺”(比如逻辑漏洞、事实错误),再针对性改进。细节:训练中还引入了预算控制(限制生成长度)和温度衰减(降低随机性),让回答既精准又稳定。

原因4、硬件支撑:NVIDIAH800集群“狂飙”算力

训练万亿参数模型,没硬件支持就是“巧妇难为无米之炊”。KimiK2背后是NVIDIAH800GPU组成的高带宽集群,优势明显:

算力管够:H800的张量核心性能比上一代提升3倍,训练速度直接起飞。数据传输快:高带宽网络让多卡并行训练时“零延迟”,避免“卡脖子”。团队透露:这套集群让KimiK2的训练效率比普通方案高40%,成本却低了25%。

结语:开源模型的“卷王”来了,但竞争才刚开始

KimiK2的发布,不仅是技术实力的展示,更是开源社区对闭源巨头的“宣战书”——用更低的成本、更高的灵活性,让AI技术触手可及。

对开发者来说,KimiK2的开源意味着能直接“白嫖”顶尖模型,甚至基于它二次开发(比如定制行业大模型)。而对行业,这或许会掀起新一轮“开源vs闭源”的竞赛。

最后说句实在的:AI的未来,从来不是少数公司的游戏。当越来越多像KimiK2这样的“狠角色”出现,技术的普惠,或许比我们想象中来得更快。