Farfalle.dev是一个开源ai驱动的答案AI搜索引擎,定位为Perplexity的自托管替代品。它允许用户运行本地大型语言模型(LLMs),例如llama3、gemma、mistral和phi3,或通过LiteLLM使用自定义LLMs。此外,它还支持Groq/Llama3和OpenAI的GPT-4和GPT-3.5-turbo24等云模型。

Farfalle主要特征:

搜索提供商:Farfalle与多个搜索提供商集成,包括Tavily、Searxng、Serper和Bing2。

本地和云模型:用户可以使用本地模型(llama3、mistral、gemma、phi3)或云模型(OpenAI/gpt4-o、OpenAI/gpt3.5-turbo、Groq/Llama3)回答问题2。

自定义LLMs:通过LiteLLM,Farfalle支持自定义LLMs,增强其灵活性2。

技术堆栈:前端使用Next.js构建,后端使用FastAPI构建。它还使用Redis进行速率限制,使用Logfire进行日志记录2。

部署选项:Farfalle可以使用Docker或在Render和Vercel24等平台上部署。

Farfalle入门:

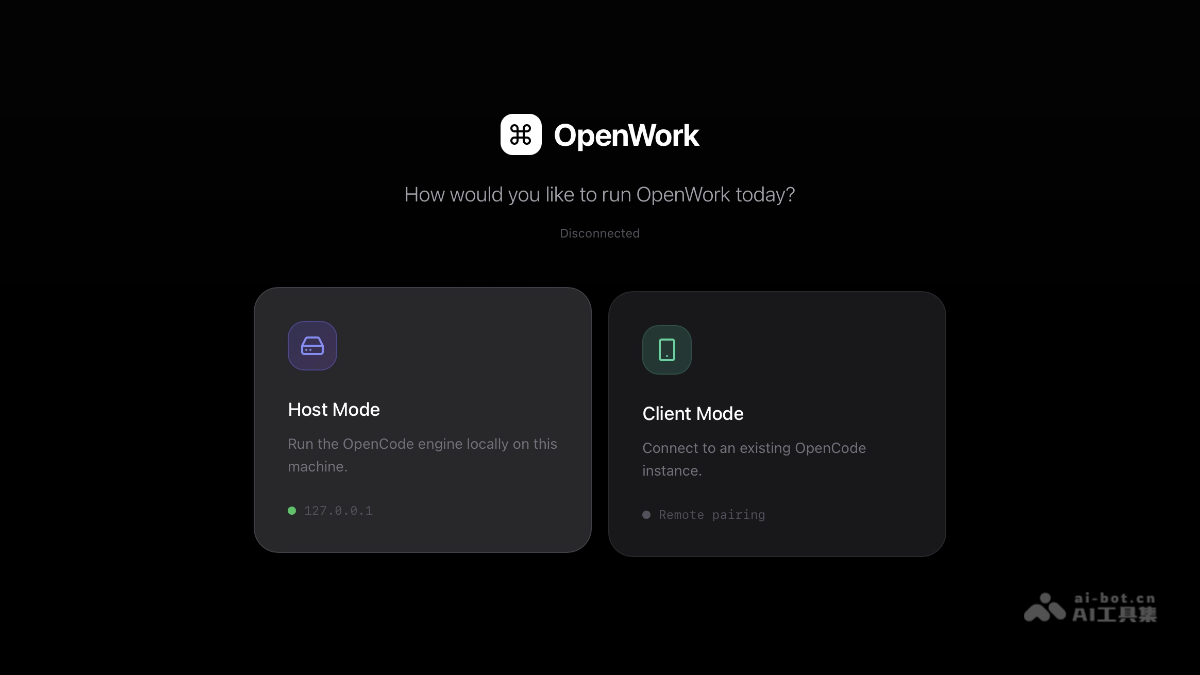

要在本地开始使用Farfalle:

先决条件:如果运行本地模型,请确保安装了Docker和Ollama。

API密钥:获取Tavily、Serper、OpenAI、Bing和Groq等可选服务的API密钥。

运行命令:

访问http://localhost:3000访问应用程序.

Farfalle源代码可在GitHub上获取。https://github.com/rashadphz/farfalle