今天,我们发布了稳定版Zero123,这是我们内部训练的模型,用于生成视图条件图像。与之前最先进的Zero123-XL相比,稳定的Zero123产生了显着改善的结果。这是通过3项关键创新实现的:

1、改进的训练数据集,从Objaverse中大量过滤,只保留高质量的3D对象,我们渲染的对象比以前的方法更加真实。

2、在训练和推理过程中,我们为模型提供了估计的摄像机角度。这种海拔调节使其能够做出更明智、更高质量的预测。

3、预先计算的数据集(预先计算的潜在变量)和改进的数据加载器支持更高的批量大小,与第一个创新相结合,与Zero123-XL相比,训练效率提高了40倍。

Zero123特征:

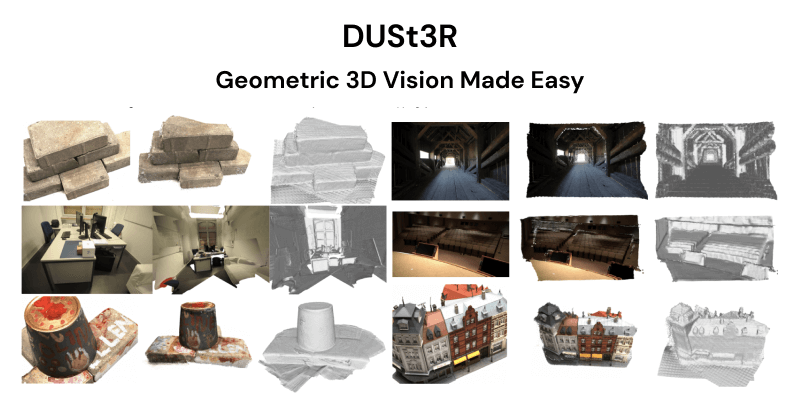

稳定的Zero123可以生成物体的新颖视图,展示从各个角度对物体外观的3D理解,由于训练数据集和高程条件的改进,其质量比Zero1-to-3或Zero123-XL显着提高。

该模型基于稳定扩散1.5,消耗与SD1.5相同数量的VRAM来生成1个新视图。使用StableZero123生成3D对象需要更多时间和内存(建议使用24GBVRAM)。

为了实现3D对象生成方面的开放研究,我们改进了Threestudio开源代码的开源代码,以支持Zero123和StableZero123。Stable3D流程的简化版本目前处于私人预览阶段。从技术角度来说,这使用分数蒸馏采样(SDS)来使用稳定的Zero123模型来优化NeRF,稍后我们可以从中创建纹理3D网格。该过程可以适用于文本到3D生成,首先使用SDXL生成单个图像,然后使用StableZero123生成3D对象。

Zero123项目:https://github.com/cvlab-columbia/zero123

Zero123试用:https://huggingface.co/spaces/cvlab/zero123-live

Zero123论文:https://arxiv.org/abs/2303.11328

该模型现已发布在HuggingFace上,研究人员和非商业用户可以下载并进行实验。