如何在Replicate上运行自然语言处理模型?在Replicate上运行自然语言处理(NLP)模型的步骤相对直接,以下是一个详细的指南:

一、准备工作

- 注册与登录:

- 访问Replicate的官方网站,注册一个账户并登录。

- 获取API密钥:

- 登录后,在账户设置或API管理部分获取你的API密钥。这个密钥将用于在代码中调用Replicate的API。

- 安装必要的Python库:

- 使用pip安装llama-index和llama-index-llms-replicate库,这些库将帮助你与Replicate平台上的模型进行交互。

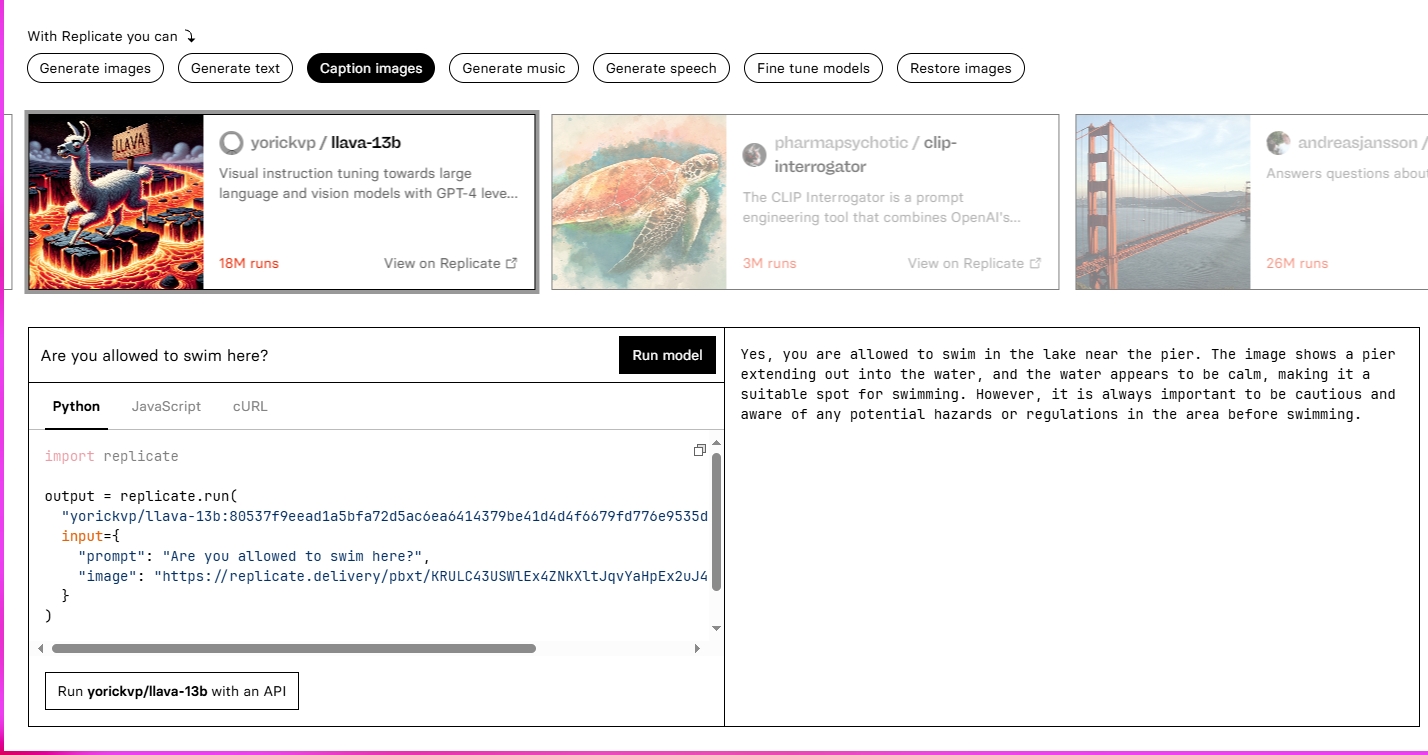

二、选择并准备NLP模型

- 浏览模型库:

- 在Replicate的探索页面,查找适合你的自然语言处理任务的模型。例如,你可以选择用于文本生成、情感分析、命名实体识别等任务的模型。

- 复制模型ID:

- 找到你感兴趣的模型后,复制其模型ID。这个ID将用于在代码中指定要调用的模型。

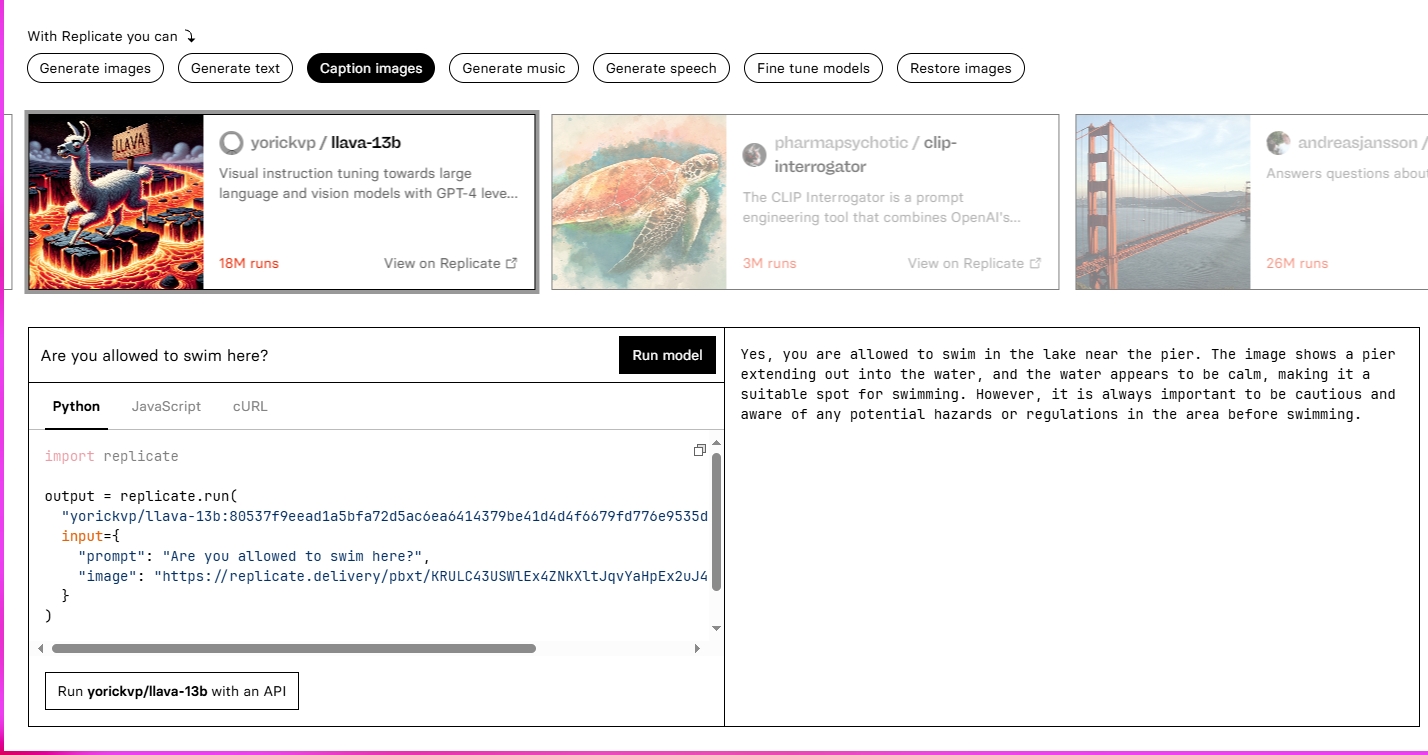

三、编写代码并调用模型

-

设置环境变量:

- 在你的Python代码中,设置REPLICATE_API_TOKEN环境变量,并将其值设置为你之前获取的API密钥。

python复制代码import osos.environ["REPLICATE_API_TOKEN"] = "<your_api_key>" # 请替换为你的API密钥 -

导入必要的库:

- 导入llama-index库中的相关模块,以便与Replicate平台上的模型进行交互。

-

创建模型实例:

- 使用你复制的模型ID创建一个Replicate模型的实例。

python复制代码from llama_index.llms.replicate import Replicatellm = Replicate(model="replicate/<your_model_id>") # 请替换为你的模型ID -

准备输入数据:

- 根据模型的要求准备输入数据。对于NLP模型,输入数据通常是文本字符串。

-

调用模型:

- 使用模型实例的方法调用模型,并传递输入数据。对于文本生成任务,你可以使用

complete方法;对于对话任务,你可以使用chat方法。

python复制代码# 示例:使用complete方法进行文本补全resp = llm.complete("Your input text here") # 请替换为你的输入文本print(resp)# 示例:使用chat方法进行对话from llama_index.core.llms import ChatMessagemessages = [ChatMessage(role="system", content="Your system message here"), # 可选的系统消息ChatMessage(role="user", content="Your user message here") # 用户的输入消息]resp = llm.chat(messages)print(resp) - 使用模型实例的方法调用模型,并传递输入数据。对于文本生成任务,你可以使用

四、处理输出结果

- 解析输出结果:

- 根据模型的输出格式解析输出结果。对于NLP模型,输出通常是文本字符串或包含文本字符串的字典。

- 处理错误:

- 检查输出结果中是否有错误或异常。如果有,根据错误信息进行处理或调试。

五、优化与部署

- 调整模型参数:

- 根据需要调整模型的参数,如温度(控制生成文本的随机性)和最大生成的tokens数量。

- 部署模型:

- 如果你的模型表现良好,你可以考虑将其部署到生产环境或集成到你的应用程序中。

- 监控与维护:

- 监控模型的运行状态和性能,及时进行维护和更新。

通过以上步骤,你可以在Replicate上成功运行自然语言处理模型,并获取有用的输出结果。记得在调用模型时替换占位符为实际的值,并根据你的具体需求调整代码。