什么是MCP(Model-Context-Protocol)

文章来源:智汇AI 发布时间:2025-04-07

模型上下文协议(Model Context Protocol,MCP)是一种开放协议,让大型语言模型(LLM)与外部工具和数据源实现无缝通信。通过统一的协议实现各类数据源的插件式接入,避免为每个数据源单独编写代码。确保在数据交互过程中,敏感信息(如API密钥、用户数据)得到充分保护。

暂无访问MCP(Model Context Protocol,模型上下文协议)是 Anthropic 推出的开放协议,让大型语言模型(LLM)与外部工具和数据源实现无缝通信。采用客户端–服务器架构,通过标准化接口,让LLM应用能安全、高效地连接到各种数据源和工具,如数据库、文件系统、第三方API等。MCP的核心优势在于统一性、安全性和扩展性。支持工具、资源和提示三种功能,能帮助用户完成多种任务,如文件管理、信息查询、沟通辅助等。MCP协议为AI与外部数据资源的连接提供了标准化桥梁,有望推动AI应用的进一步发展和普及。

什么是模型上下文协议

模型上下文协议(Model Context Protocol,MCP)是一种开放协议,让大型语言模型(LLM)与外部工具和数据源实现无缝通信。通过统一的协议实现各类数据源的插件式接入,避免为每个数据源单独编写代码。确保在数据交互过程中,敏感信息(如API密钥、用户数据)得到充分保护。

模型上下文协议的工作原理

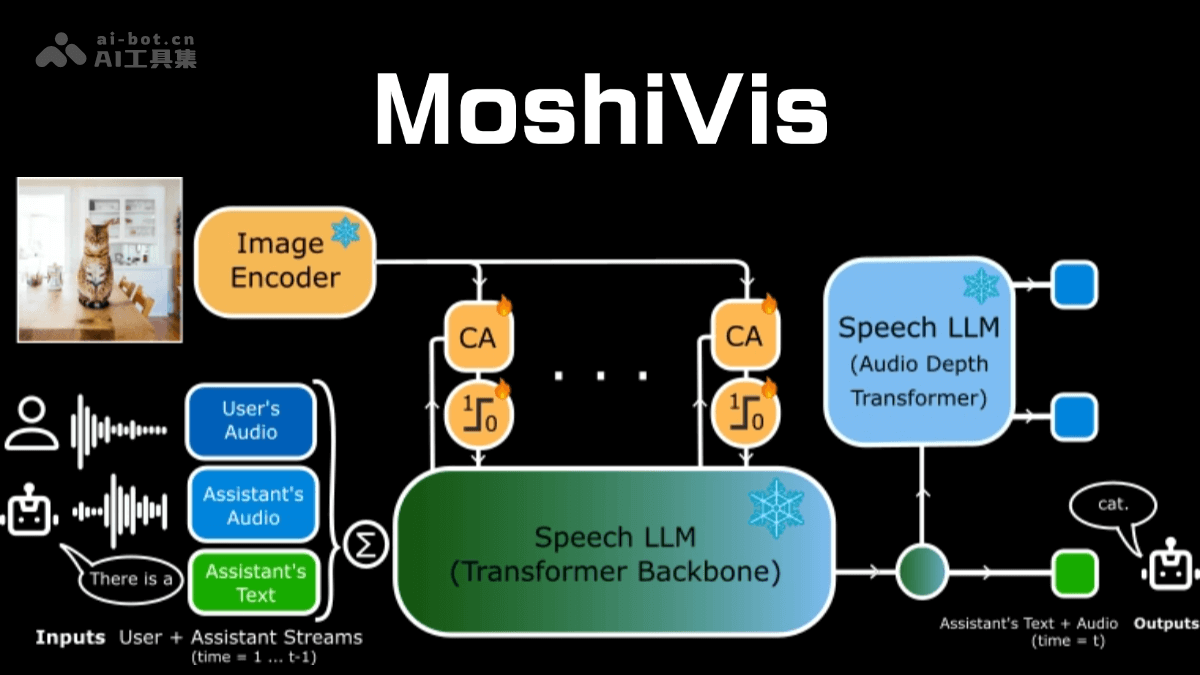

MCP(Model Context Protocol,模型上下文协议)的工作原理基于客户端–服务器架构,通过标准化的通信协议实现大型语言模型(LLM)与外部工具和数据源的无缝集成。

MCP的核心架构主要由三个组件构成:

MCP主机(Host):是用户使用的AI工具或应用程序(例如Claude Desktop、IDE插件等),同时充当MCP客户端,用于发起与外部资源的连接。MCP服务器(Server):一个轻量级服务,用于连接具体的数据源或工具(如数据库、文件系统、第三方API等)。每个MCP服务器通常专注于一种特定的资源或功能。协议层:采用JSON-RPC或gRPC等标准通信协议,保证主机与服务器之间的消息传递安全、快速且一致。MCP的工作原理及流程:

初始化连接:客户端向服务器发送连接请求,建立通信通道。发送请求:客户端根据需求构建请求消息,并发送给服务器。处理请求:服务器接收到请求后,解析请求内容,执行相应的操作(如查询数据库、读取文件等)。返回结果:服务器将处理结果封装成响应消息,发送回客户端。断开连接:任务完成后,客户端可以主动关闭连接或等待服务器超时关闭。MCP支持两种主要的通信机制:

本地通信:通过标准输入输出(stdio)传输数据,适用于在同一台机器上运行的客户端和服务器之间的通信。远程通信:用SSE(Server-Sent Events)与HTTP结合,实现跨网络的实时数据传输,适用于需要访问远程资源或分布式部署的场景。MCP服务器可以提供三种主要类型的功能:

工具(Tools):可以被LLM调用的函数,需要用户批准才能执行,例如获取天气预报、查询数据库等。资源(Resources):可以被客户端读取的类文件数据,如API响应或文件内容。提示(Prompts):帮助用户完成特定任务的预设模板,优化LLM的输出。通过以上设计,MCP简化了AI与外部数据源和工具的集成过程,提供了更高的安全性和灵活性。