什么是对比语言-图像预训练(Contrastive-Language-Image-Pretraining,-CLIP)

文章来源:智汇AI 发布时间:2025-04-08

对比语言-图像预训练(Contrastive Language-Image Pretraining, CLIP)是OpenAI开发的一种多模态预训练神经网络模型,通过对比学习的方法,实现了图像与文本之间的有效映射和关联。CLIP模型包含两个独立的编码器:一个用于处理图像,另一个用于处理文本,这两个编码器分别将图像和文本转换为高维特征向量,通过计算这些特征向量之间的相似度来评估图像和文本之间的关联程度。

暂无访问对比语言-图像预训练(Contrastive Language-Image Pretraining, CLIP)是OpenAI开发的一种多模态预训练神经网络模型,通过对比学习的方法,实现了图像与文本之间的有效映射和关联。CLIP模型包含两个独立的编码器:一个用于处理图像,另一个用于处理文本,这两个编码器分别将图像和文本转换为高维特征向量,通过计算这些特征向量之间的相似度来评估图像和文本之间的关联程度。CLIP的核心优势在于其零样本学习能力,能在没有直接优化特定任务的情况下,通过自然语言指令预测最相关的文本片段或图像。这种能力使得CLIP在图像分类、图像检索、文本到图像的检索等多种应用场景中展现出广泛的应用潜力。

什么是对比语言-图像预训练

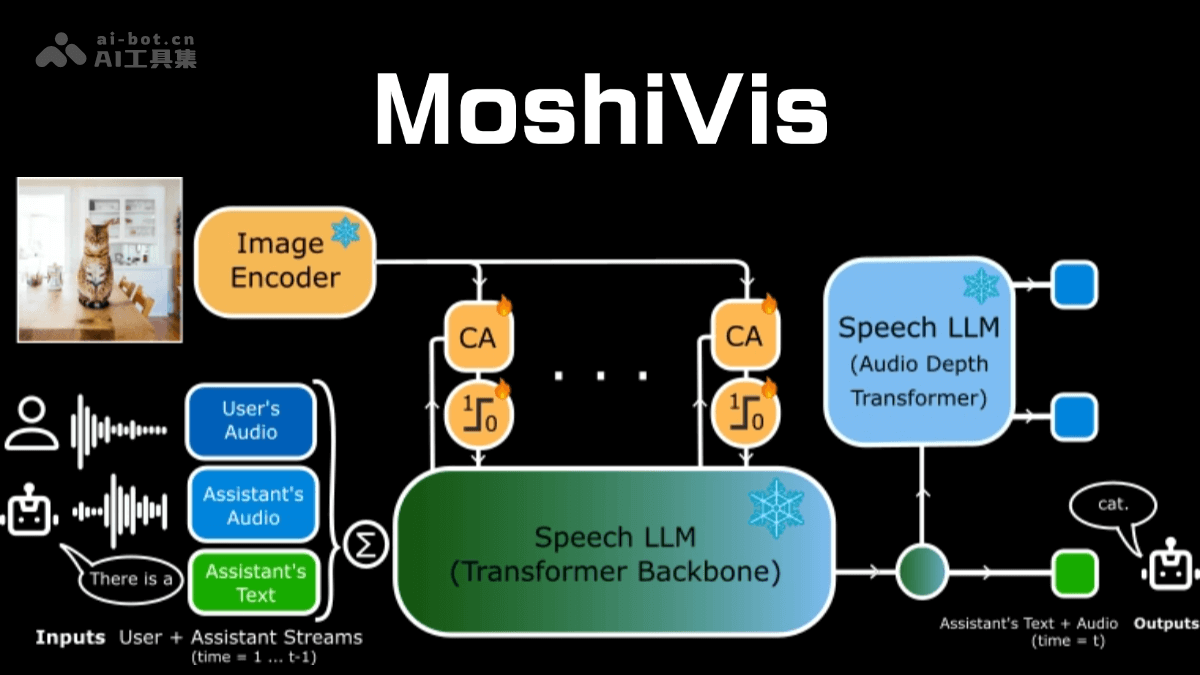

对比语言-图像预训练(Contrastive Language-Image Pretraining, CLIP)是OpenAI开发的一种多模态预训练神经网络模型,通过对比学习的方法,实现了图像与文本之间的有效映射和关联。CLIP模型的核心思想是通过对比学习来预训练一个模型,能理解图像和文本之间的关系。包含两个独立的编码器:一个用于处理图像,另一个用于处理文本。这两个编码器分别将图像和文本转换为高维特征向量,通过计算这些特征向量之间的相似度来评估图像和文本之间的关联程度。

对比语言-图像预训练的工作原理

CLIP(Contrastive Language-Image Pretraining)模型的工作原理可以概括为“对比学习”。在预训练阶段,CLIP通过对比图像和文本的向量表示,学习它们之间的匹配关系。具体来说,模型会接收一批图像-文本对作为输入,尝试将匹配的图像和文本向量在共同的语义空间中拉近,将不匹配的向量推远。将图像和文本分别通过各自的编码器嵌入到共享的多维语义空间中。这个空间被设计成能够捕捉文本描述和图像内容之间的语义关系。通过计算图像和文本向量之间的余弦相似度,来评估它们之间的匹配程度。在预测阶段,CLIP通过计算文本和图像向量之间的余弦相似度来生成预测结果。

CLIP的训练依赖于大规模的图像-文本数据集。OpenAI构建了一个名为WIT(WebImageText)的数据集,包含了从互联网上收集的4亿个图像-文本对。数据集涵盖了广泛的视觉和文本概念,为CLIP提供了丰富的训练素材。在训练过程中,CLIP模型通过优化对称交叉熵损失函数,使匹配的图像-文本对的相似度尽可能高,不匹配的则尽可能低。这种训练方式使CLIP能在没有显式监督标签的情况下,学习到图像和文本之间的深层语义关系。

对比语言-图像预训练的主要应用

零样本图像分类(Zero-Shot Image Classification):CLIP模型能在未见过的类别上进行图像分类。基于学习到的强大视觉和语言关联。文本到图像检索(Text-to-Image Retrieval):用户可以通过输入文本描述来检索与描述最相关的图像。在搜索引擎、电子商务网站和图像数据库等领域,可以提高检索的效率和准确性。图像到文本检索(Image-to-Text Retrieval):与文本到图像检索相反,图像到文本检索是根据图像检索最匹配的文本描述。视觉问题回答(Visual Question Answering):CLIP模型可以用于视觉问题回答系统,通过理解和分析图像及问题文本,生成与问题相关的答案。图像描述生成(Image Captioning):CLIP模型可以与文本生成模型结合使用,以生成与图像内容相匹配的文本描述。可以将图像编码为向量,然后将该向量作为文本生成模型的输入,生成描述性文本。风格迁移和图像编辑(Style Transfer and Image Manipulation):CLIP模型可以用于指导风格迁移和图像编辑任务。通过计算目标风格或编辑后图像的CLIP嵌入与原始图像的CLIP嵌入之间的距离,可以评估风格迁移或编辑的效果,进行相应的优化。多模态搜索(Multi-Modal Search):CLIP模型可以接受文本、图像或混合输入来检索相关信息。在需要同时处理文本和图像信息的场景中。图像标注(Image Annotation):基于CLIP的零样本学习能力,可以自动为图像生成准确的文本描述,提高图像标注的效率和准确性。跨模态检索(Cross-Modal Retrieval):CLIP可以应用于跨模态检索领域,实现文本到图像或图像到文本的快速检索。视觉识别(Visual Recognition):CLIP模型通过结合图像分类和对比语言图像预训练,提高了视觉识别的性能。对比语言-图像预训练面临的挑战

CLIP(Contrastive Language-Image Pretraining)模型自推出以来,已经在多模态学习领域取得显著的成果,但未来的发展仍然面临着一系列挑战:

细粒度视觉表示的需求:随着多模态任务对视觉理解的要求越来越高,CLIP模型需要能提供更细粒度的视觉表示。大规模训练数据的需求:CLIP模型的训练依赖于大规模的图像-文本对数据集。虽然已经有一些公共数据集提供了区域-文本注释,但这些数据集的规模通常不足以支持CLIP模型的训练需求。训练成本和资源消耗:CLIP模型的训练成本高昂,需要消耗大量的计算资源和时间。CLIP模型的参数量也相对较大,需要更多的计算资源来训练和优化。模型泛化能力的提升:尽管CLIP模型在多个自然语言处理任务中表现优异,但对于某些特定任务的表现却并不理想。可能是因为这些任务需要特定的知识和技能,而CLIP预训练模型在这些方面的学习能力有限。模型的可解释性和透明度:CLIP模型的决策过程和输出往往难以解释和监控,降低了模型的透明度。在一些需要高度可解释性的应用场景中,如医疗诊断或法律领域,这种黑盒问题可能会成为CLIP模型应用的障碍。模型的鲁棒性和安全性:CLIP模型在面对对抗性攻击时的鲁棒性仍然是一个挑战。模型可能会学习到数据中的偏见,在某些情况下产生不公平或歧视性的结果。多模态任务的复杂性:随着多模态任务的复杂性不断增加,CLIP模型需要能处理更加复杂的场景和任务。跨模态对齐的准确性:CLIP模型通过对比学习来实现图像和文本之间的对齐,在某些情况下,这种对齐可能不够准确。模型的实时性能:在一些需要实时响应的应用场景中,如自动驾驶或实时翻译,CLIP模型的实时性能是一个重要的考虑因素。目前,CLIP模型的推理速度可能还不够快,无法满足这些实时应用的需求。模型的可扩展性:随着数据量和模型规模的不断增长,CLIP模型的可扩展性成为一个挑战。未来的研究需要探索如何设计更加高效的模型架构和训练算法,支持更大规模的数据集和模型。对比语言-图像预训练的发展前景

CLIP模型作为多模态学习的代表,发展前景与该领域的技术进步紧密相关。随着多模态学习技术的发展,有望在图像和文本联合表示学习方面取得更多突破。CLIP模型在零样本学习任务中展现出了强大的能力,未来可能会在少样本学习领域也取得进展,使模型在标注数据稀缺的情况下也能发挥良好作用。知识增强的CLIP模型(Knowledge-CLIP)通过引入知识图谱,进一步提升了模型的语义对齐能力和跨模态推理能力。这种融合知识的方法可能会成为提升CLIP模型性能的一个新趋势。CLIP模型在图像搜索和跨模态检索方面已经展现出了强大的能力,未来可能会在这一领域进一步优化,提供更加精准和高效的检索服务。CLIP模型的发展前景包括在多模态学习、零样本学习、3D视觉理解、知识图谱融合、跨模态检索、模型可解释性、实时性能优化以及处理复杂多模态任务等方面的进步和应用。随着技术的不断发展,CLIP模型有望在更多领域发挥重要作用。