字节跳动EX-4D开源:单目视频秒变自由视角4D大片

文章来源:智汇AI 发布时间:2025-07-04

字节跳动旗下PICO - MR团队近日有大动作,正式开源突破性4D视频生成框架EX - 4D。它能将单目视频秒变高质量、多视角4D视频序列,在技术指标上领先现有开源方法,还为沉浸式3D内容创作等提供…

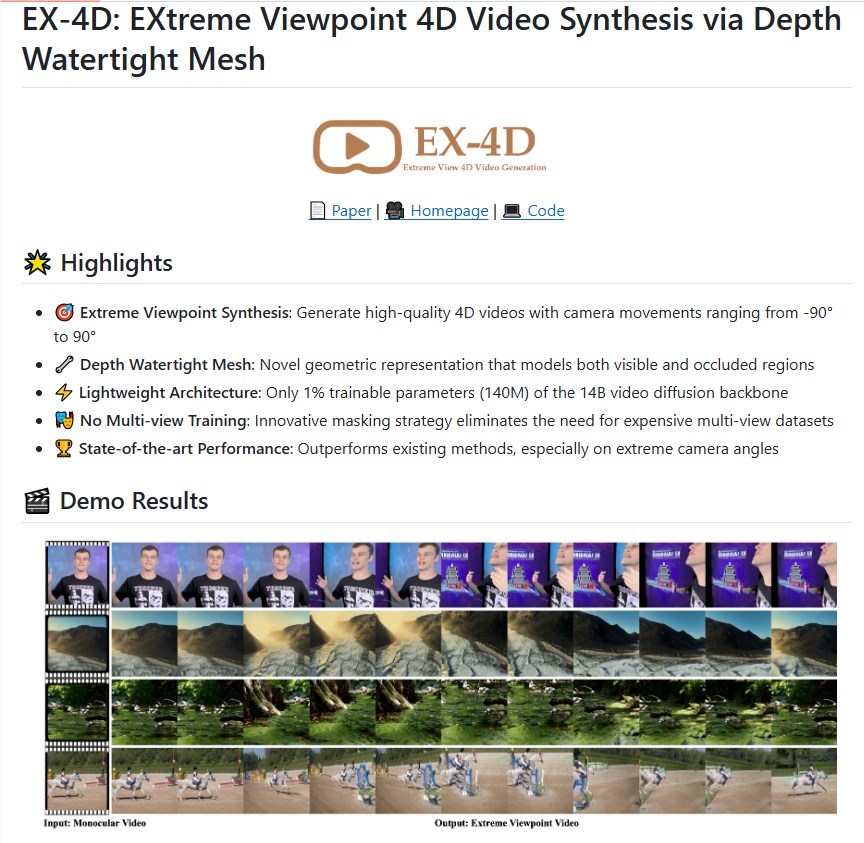

暂无访问字节跳动PICO-MR团队开源EX-4D,4D视频生成框架引关注EX-4D是什么?

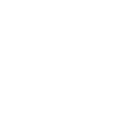

近日,字节跳动旗下PICO-MR团队干了一件大事——正式开源了EX-4D,这可是一个具有突破性的4D视频生成框架。简单来说,它能把单一视角(也就是单目)的视频,变成高质量、多视角的4D视频序列。这里的4D,指的是3D空间加上时间维度。

这一成果,无疑是视频生成技术发展路上的一个重要里程碑。而且,EX-4D不仅在技术指标上把现有的开源方法远远甩在后面,还为沉浸式3D内容创作以及“世界模型”的构建提供了关键支持。下面咱就好好唠唠这个前沿技术。

EX-4D开源地址

github地址:https://github.com/tau-yihouxiang/EX-4D

技术突破:传统技术难题重重

传统视频生成技术在多视角生成方面,一直被两大难题困扰。一方面,训练需要用到昂贵的多视角相机和大量的数据集,这成本可不是一般的高。另一方面,处理遮挡区域特别费劲,导致生成的视频在极端视角下,不是物体穿帮,就是细节失真,看着特别别扭。

EX-4D创新解难题

EX-4D能成功解决这些问题,靠的是深度密闭网格(DW-Mesh)表示和轻量级适配架构这两个创新点。

DW-Mesh:核心技术显神通

DW-Mesh是EX-4D的核心技术。它通过构建全密闭网格结构,把场景里的可见和隐形面片都记录下来。这样一来,就算没有多视角监督,也能统一处理复杂场景拓扑。再结合预训练深度预测模型,EX-4D能把单帧像素投影到3D空间,形成网格顶点,还能根据几何关系精准标记遮挡区域。有了它,生成的视频就算在极端视角(比如±90°)下,也能保持物理一致性和细节完整性,不会出现那些让人尴尬的穿帮和失真情况。

模拟mask生成策略:破解数据稀缺难题

EX-4D还引入了两种模拟mask生成策略——渲染mask和跟踪mask。这两种策略通过模拟视角移动和帧间一致性,成功破解了多视角训练数据稀缺的难题。有了它们,EX-4D仅凭单目视频就能“脑补”出全视角数据,大大降低了数据采集成本。

性能表现:性能测试成绩优异

EX-4D在性能测试中的表现那叫一个出色。基于包含150个网络视频的数据集,它在FID(弗雷歇距离)、FVD(弗雷歇视频距离)和VBench等行业标准指标上,全面超越了现有的开源方法。特别是在极端视角(接近90°)的生成任务中,EX-4D的优势更加明显,生成的视频在物体细节和遮挡逻辑上表现得更加真实。

主观评估获认可

除了客观的性能测试,还有一项主观评估。50位志愿者参与其中,结果有70.7%的参与者认为,EX-4D在极端视角下的物理一致性远远超过其他开源方法。这说明EX-4D不仅在技术指标上领先,在实际应用中也得到了用户的高度认可。

开源共享:完全开源惠及全球开发者

字节跳动把EX-4D完全开源了,代码和相关文档都发布在了GitHub上,全球开发者都能免费访问。这一举措不仅体现了字节跳动对开源社区的贡献,也为沉浸式3D电影、虚拟现实(VR)、增强现实(AR)等领域的创新应用奠定了基础。

轻量级设计适用广泛场景

EX-4D基于预训练的WAN-2.1模型,结合LoRA-basedAdapter架构,在保持计算效率的同时,融入了DW-Mesh的几何先验信息,确保生成视频的几何一致性和帧间连贯性。这种轻量级设计让EX-4D在资源受限的环境下也能高效运行,适合各种开发场景。

构建“世界模型”的重要进展

EX-4D的发布被看作是构建“世界模型”的重要进展。和传统的单向视频生成模型不同,EX-4D让用户有了自由探索视频内容的能力,就像在“平行宇宙”里切换视角一样。这种相机可控的4D生成技术,为沉浸式内容创作带来了无限可能,比如交互式3D电影、虚拟旅游和游戏开发等。

字节跳动PICO-MR团队负责人表示,EX-4D是团队在3D重建与4D场景生成领域多年研究的成果。

未来,团队还会继续优化模型性能,探索更广泛的应用场景。可以预见,EX-4D的开源将加速AI视频生成技术的普及,推动多模态AI在创意产业中更好地落地。