Jamba-AI21开源的首个基于Mamba架构的大模型

文章来源:智汇AI 发布时间:2025-08-06

Jamba是由AI21 Labs推出的首个基于Mamba架构的生产级别的大语言模型,目前大部分的大模型(如GPT、Gemini 和 Llama)都是基于 Tra

暂无访问Jamba是什么

Jamba是由AI21 Labs推出的首个基于Mamba架构的生产级别的大语言模型,目前大部分的大模型(如GPT、Gemini 和 Llama)都是基于 Transformer 结构。而 Jamba 结合了 Mamba 结构化状态空间模型(SSM)和 传统Transformer 架构,兼具了高质量输出、高吞吐量和低内存占用的优点。该混合结构的模型提供了256K的上下文窗口,显著提升了处理长文本时的吞吐量和效率。

Jamba 以开放权重的形式发布,遵循Apache 2.0开源许可,鼓励社区进行进一步的研究和优化。目前,Jamba 目前作为研究模型发布,没有必要的商业用途保障。AI21 Labs 计划在未来几周内发布一个经过微调、更安全的版本。

Jamba的官网入口

官方项目主页:https://www.ai21.com/jamba官方博客介绍:https://www.ai21.com/blog/announcing-jambaHugging Face地址:https://huggingface.co/ai21labs/Jamba-v0.1Jamba的主要特性

SSM-Transformer混合架构:Jamba是首个采用Mamba SSM(结构化状态空间模型)与Transformer架构相结合的生产级模型,这种创新的混合架构旨在提升模型的性能和效率。大容量上下文窗口:Jamba提供了256K的上下文窗口,这使得模型能够处理更长的文本序列,适用于更复杂的自然语言处理任务。高吞吐量:相比于同等规模的Mixtral 8x7B模型,Jamba在处理长上下文时实现了3倍的吞吐量提升,可以更高效地处理大量数据。单GPU大容量处理:Jamba能够在单个GPU上处理高达140K的上下文,显著提高了模型的可访问性和部署的灵活性。开放权重许可:Jamba的权重以Apache 2.0许可发布,为研究者和开发者提供了自由使用、修改和优化模型的权限,促进了技术的共享和创新。NVIDIA API集成:Jamba将作为NVIDIA NIM推理微服务在NVIDIA API目录中提供,使得企业开发者可以利用NVIDIA AI Enterprise软件平台轻松部署Jamba模型。优化的MoE层:Jamba利用混合结构中的MoE(混合专家)层,在推理时只激活部分参数,提高了模型的运行效率和性能。Jamba的技术架构

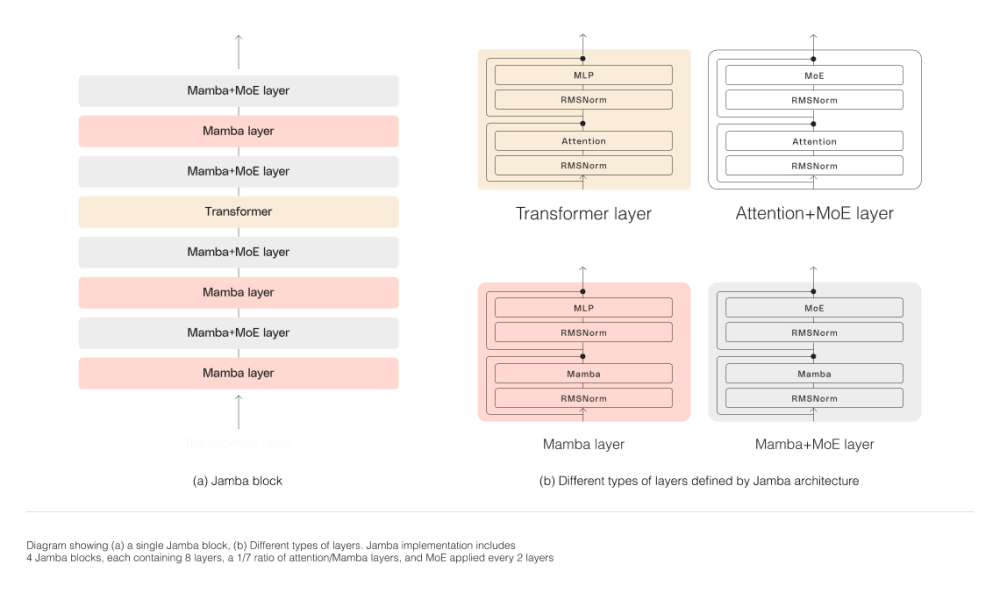

Jamba 架构采用块和层方法,使 Jamba 能够成功集成 Mamba SSM 和 Transformer两种架构。每个 Jamba 块包含一个注意力层或一个 Mamba 层,后跟一个多层感知器 (MLP),从而产生每八层中一个 Transformer 层的总体比例。

此外,Jamba 利用 MoE 来增加模型参数的总数,同时简化推理中使用的活动参数的数量,从而在计算需求没有相应增加的情况下获得更高的模型容量。为了最大限度地提高单个 80GB GPU 上的模型质量和吞吐量,AI21 Labs 优化了所使用的 MoE 层和专家的数量,为常见推理工作负载留下了足够的可用内存。

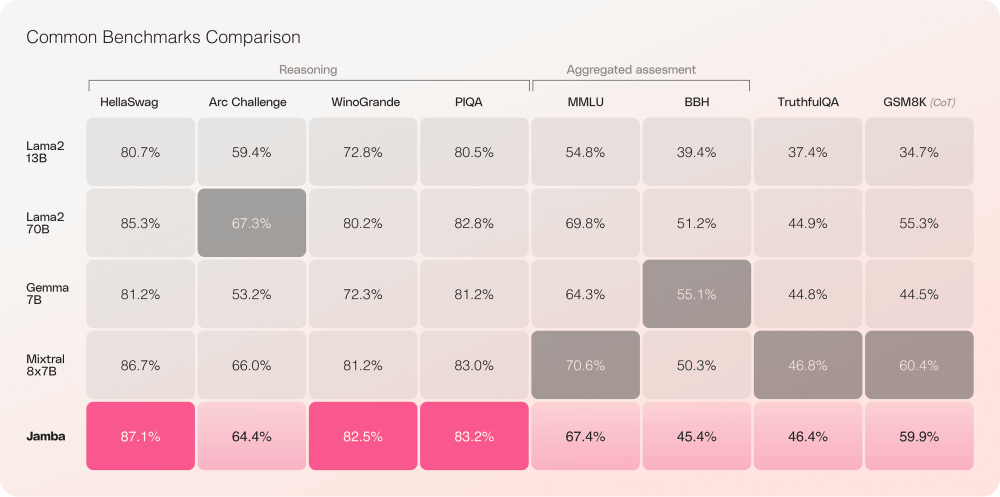

Jamba的性能对比

根据 AI21 Labs 的报告,Jamba 模型在各种基准测试(如HellaSwag、ArcChallenge、MLLU等)中展示了优秀的结果,在广泛的任务测试(如语言理解、科学推理、常识推理等)中与同尺寸类别中最先进的模型相当甚至超越(如Llama2 13B、Llama2 70B、Gemma 7B、Mixtral 8×7B)。