谷歌推理最快、成本效益最高AI模型:Gemini2.5Flash-Lite亮相,全面升级编码、翻译、推理

文章来源:智汇AI 发布时间:2025-06-21

Flash-Lite在编码、数学、科学推理及多模态任务中表现全面超越前代2.0 Flash-Lite,推理速度提升且延迟更低,适合实时翻译、分类等高吞吐量场景。

暂无访问智汇AI6月18日消息,谷歌公司今天(6月18日)发布博文,在宣布Gemini2.5Flash和Gemini2.5Pro模型进入稳定阶段之外,还推出全新轻量级模型Gemini2.5Flash-Lite。

智汇AI援引博文介绍,谷歌官方表示,Gemini2.5Flash和Gemini2.5Pro两款模型已通过大规模测试,可稳定支持生产级应用开发。Spline、Rooms等公司,以及Snap、SmartBear等企业,已在过去数周内使用最新版本开发实际应用。

谷歌表示Gemini2.5系列以平衡“成本-速度-性能”为核心设计目标,兼顾高效推理与经济性,伴随着稳定版上线,确保开发者能以更高信心构建复杂系统。

谷歌同步推出Gemini2.5Flash-Lite的预览版本,这是目前该系列中成本效益最高、推理速度最快的模型。

测试显示,Flash-Lite在代码编写、科学计算、多模态分析等任务中,综合质量超越前代2.0Flash-Lite;其延迟表现也优于2.0版本,在翻译、分类等需要快速响应的场景中尤为突出。

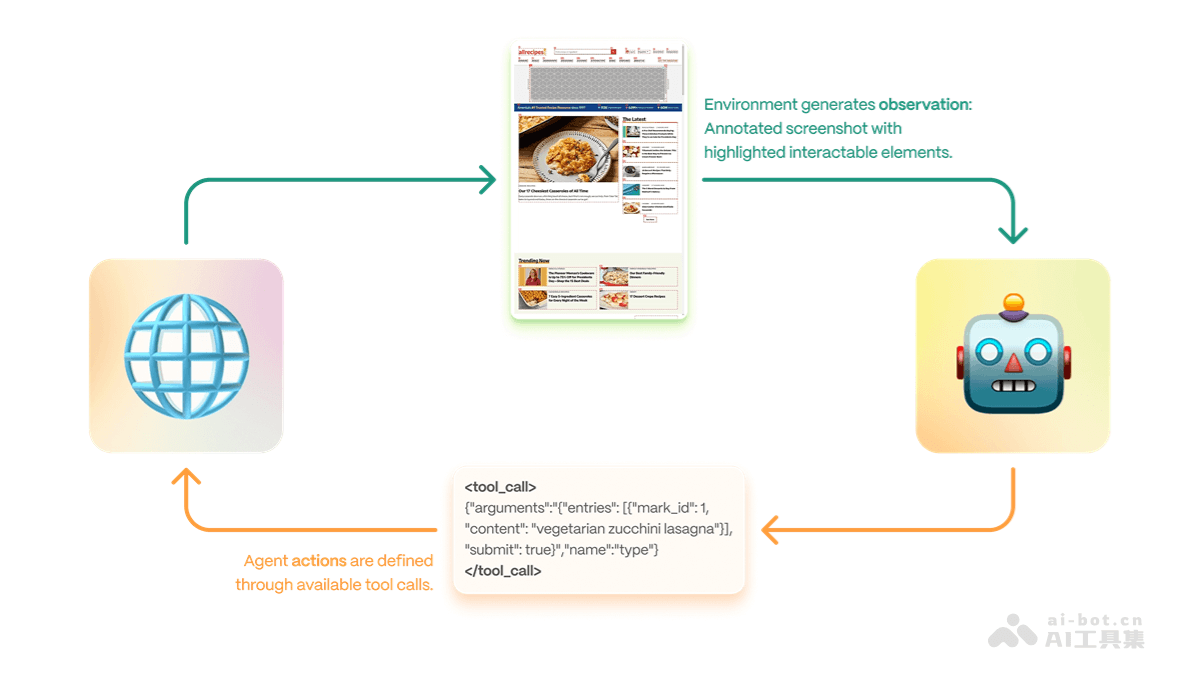

该模型继承Gemini2.5系列核心能力,包括灵活控制推理预算、连接外部工具(如谷歌搜索、代码执行)以及支持100万token超长上下文处理。

开发者可通过GoogleAIStudio、VertexAI平台访问2.5Flash和Pro的稳定版本,以及Flash-Lite的预览版本。此外,Gemini应用端也已集成2.5Flash和Pro,而谷歌搜索则部署了定制化版本的Flash-Lite和Flash模型以提升服务效率。