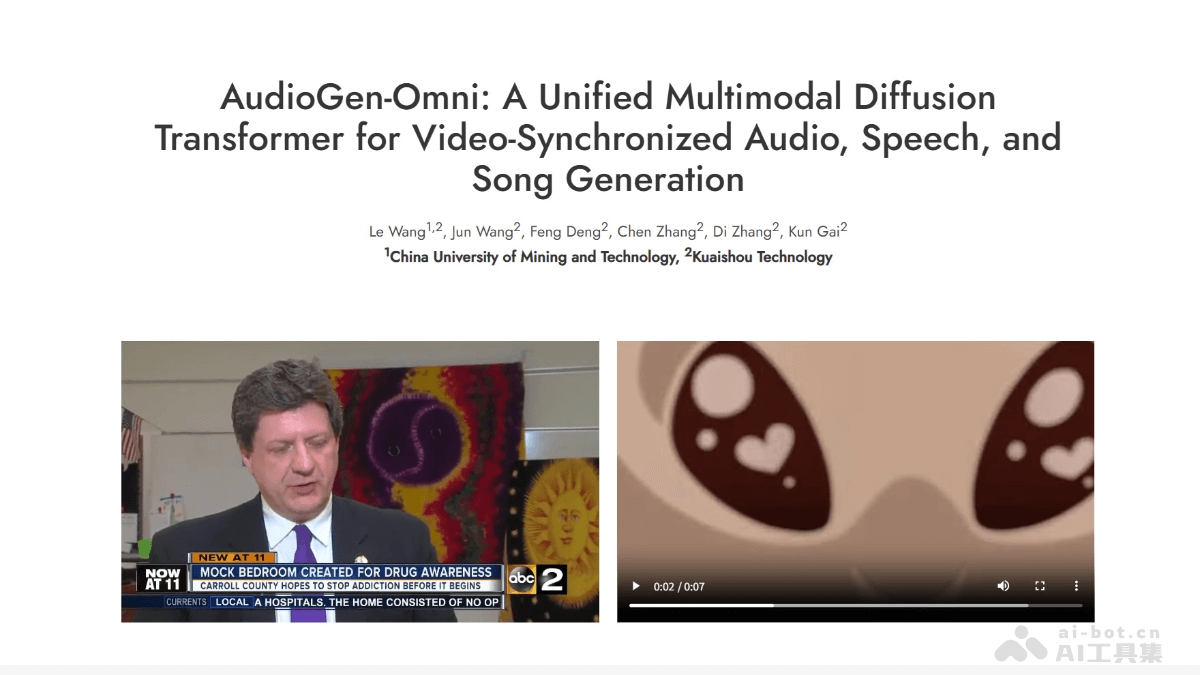

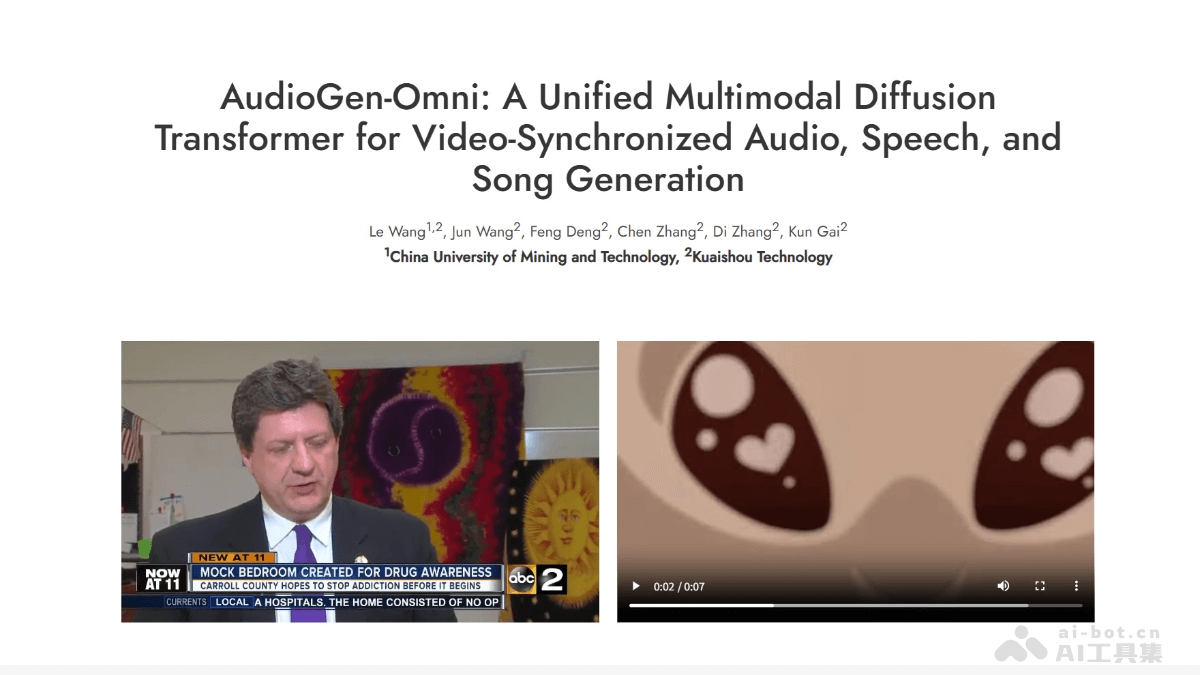

AudioGen-Omni是什么

AudioGen-Omni是快手推出的多模态音频生成框架,框架能基于视频、文本等输入生成高质量的音频、语音和歌曲。框架通过统一的歌词-文本编码器和相位对齐各向异性位置注入(PAAPI)技术,实现精准的视听对齐和跨模态同步。框架支持多语言输入,推理速度快,1.91秒能生成8秒音频,且在多种音频生成任务上表现出色,适用视频配音、语音合成和歌曲创作等场景。

AudioGen-Omni的主要功能

多模态音频生成:根据视频、文本或两者的组合生成高质量的音频、语音和歌曲。精准视听对齐:基于相位对齐各向异性位置注入(PAAPI)技术,实现音频与视频的唇音同步和节奏对齐。多语言支持:支持多种语言输入,生成对应语言的语音和歌曲。高效推理:推理速度快,1.91秒能生成8秒音频,显著优于同类模型。灵活的输入条件:能处理缺失模态的情况,即使只有视频或只有文本输入,也能生成稳定的音频输出。高质量音频生成:生成的音频在语义和声学表现上与输入高度匹配,支持高保真音频生成。

AudioGen-Omni的技术原理

多模态扩散Transformer(MMDiT):整合视频、音频和文本模态到共享语义空间,支持多种音频生成任务。基于联合训练范式,用大规模视频-文本-音频数据,增强跨模态关联。歌词-文本统一编码器:将文字(grapheme)和音素(phoneme)编码为帧级稠密表示,适配语音和歌唱任务。用多语言统一分词和ConvNeXt细化,生成帧对齐表示。相位对齐各向异性位置注入(PAAPI):选择性地将旋转位置编码(RoPE)应用于时序模态(如视频、音频),提升跨模态时序对齐精度。动态条件机制:基于解冻所有模态并掩码缺失输入,避免文本冻结范式的语义限制,支持灵活的多模态条件生成。联合注意力机制:基于AdaLN(自适应层归一化)增强跨模态特征融合,通过联合注意力机制促进跨模态信息交换。

AudioGen-Omni的项目地址

项目官网:https://ciyou2.github.io/AudioGen-Omni/arXiv技术论文:https://ciyou2.github.io/AudioGen-Omni/

AudioGen-Omni的应用场景

视频配音:为视频自动生成精准匹配的语音、歌曲或音效,提升视频创作效率和内容丰富度。语音合成:将文本快速转换为自然流畅的语音,适用于有声读物、语音助手、智能客服等领域。歌曲创作:根据视频内容或歌词生成匹配的歌曲,辅助音乐创作,丰富视频背景音乐。音效生成:根据文本描述或视频内容生成自然环境音效、动作音效等,增强内容的沉浸感。