MiniMax推出全球首个开源大规模混合架构的推理模型M1:456B参数,性能超DeepSeek-R1

文章来源:智汇AI 发布时间:2025-06-21

MiniMax 表示:M1 在面向生产力的复杂场景中能力是开源模型中的最好一档,超过国内的闭源模型,接近海外的最领先模型,同时又有业内最高的性价比。

暂无访问智汇AI6月17日消息,MiniMax稀宇科技宣布将连续五天发布重要更新。今天第一弹是开源首个推理模型MiniMax-M1。

根据官方介绍,MiniMax-M1是世界上第一个开源的大规模混合架构的推理模型。MiniMax表示:M1在面向生产力的复杂场景中能力是开源模型中的最好一档,超过国内的闭源模型,接近海外的最领先模型,同时又有业内最高的性价比。

官方博客还提到,基于两大技术创新,MiniMax-M1训练过程高效得“超出预期”,只用了3周时间、512块H800GPU就完成强化学习训练阶段,算力租赁成本仅53.47万美元(智汇AI注:现汇率约合384.1万元人民币),相比一开始的预期直接降低了一个数量级。

M1有一个显著的优势是支持目前业内最高的100万上下文的输入,跟闭源模型里面的GoogleGemini2.5Pro一样,是DeepSeekR1的8倍,以及业内最长的8万Token的推理输出。

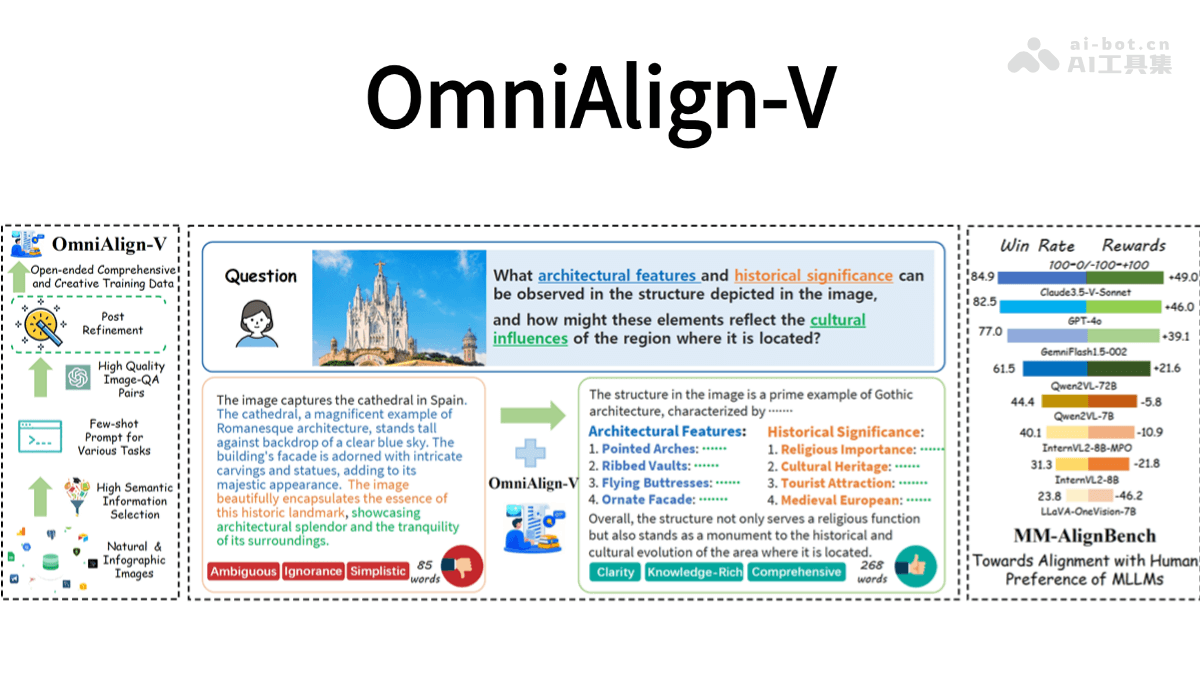

这主要得益于我们独创的以闪电注意力机制为主的混合架构,从而在计算长的上下文输入以及深度推理的时候显著高效。例如,在用8万Token深度推理的时候,只需要使用DeepSeekR1约30%的算力。这个特性使得我们在训练和推理的时候都有很大的算力效率优势。除此之外,我们提出了更快的强化学习算法CISPO,通过裁剪重要性采样权重(而非传统token更新)提升强化学习效率。在AIME的实验中,我们发现这比包括字节近期提出的DAPO等强化学习算法收敛性能快了一倍,显著的优于DeepSeek早期使用的GRPO。

得益于上述两个技术创新,我们最终强化训练过程非常高效,超出预期。实际上整个强化学习阶段只用到512块H800三周的时间,租赁成本只有53.47万美金。这比一开始的预期少了一个数量级。我们在业内主流的17个评测集上详细评测了M1,具体的结果如下:

我们发现在软件工程、长上下文与工具使用等面向生产力的复杂场景中,我们的模型具备显著优势。

MiniMax-M1-40k和MiniMax-M1-80k在SWE-bench验证基准上分别取得55.6%和56.0%的优异成绩,这一成绩略逊于DeepSeek-R1-0528的57.6%,但显著超越其他开源权重模型。

依托其百万级上下文窗口,M1系列在长上下文理解任务中表现卓越,不仅全面超越所有开源权重模型,甚至超越OpenAIo3和Claude4Opus,全球排名第二,仅以微弱差距落后于Gemini2.5Pro。

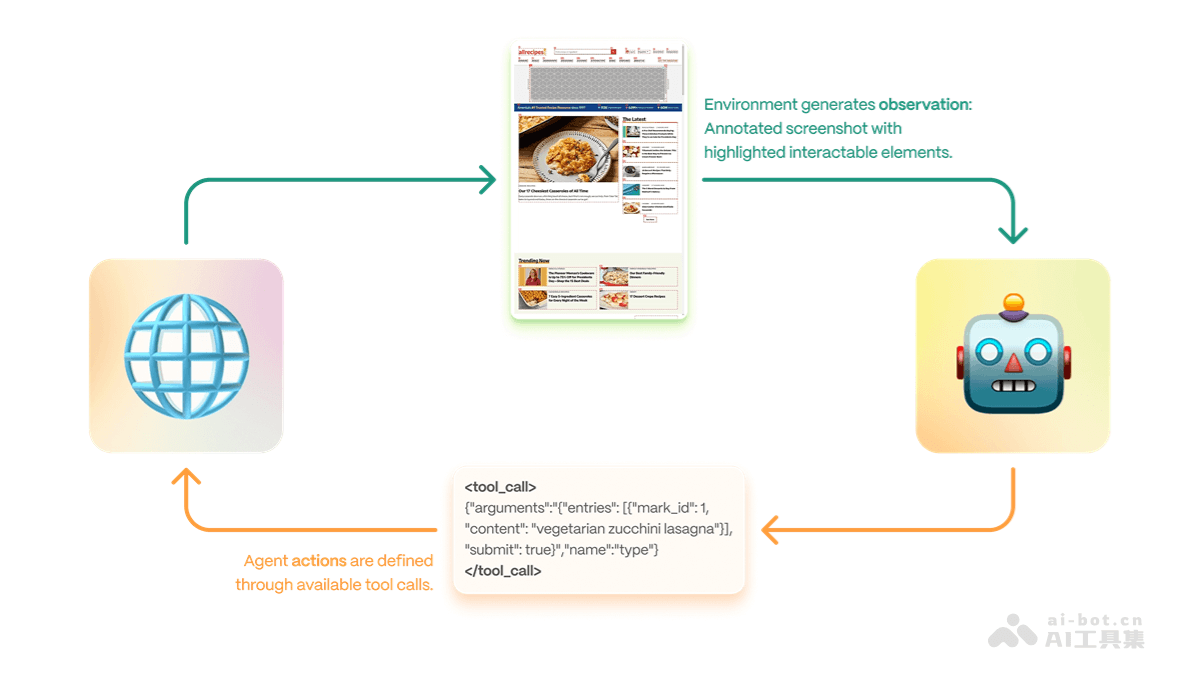

在代理工具使用场景(TAU-bench)中,MiniMax-M1-40k同样领跑所有开源权重模型,并战胜Gemini-2.5Pro。

值得注意的是,MiniMax-M1-80k在大多数基准测试中始终优于MiniMax-M1-40k,这充分验证了扩展测试时计算资源的有效性。详细的技术报告,完整的模型权重可以在我们的官方HuggingFace和GitHub账号下访问。vLLM和Transformer两个开源项目提供了各自的推理部署支持,我们也正在和SGLang合作推进部署支持。因为相对高效的训练和推理算力使用,我们在MiniMaxApp和Web上都保持不限量免费使用,并以业内最低的价格在官网提供API。在0-32k的输入长度的时候,输入0.8元/百万token,输出8元/百万token;在32k-128k的输入长度的时候,输入1.2元/百万token,输出16元/百万token;在最长的128k-1M的输入长度的时候,输入2.4元/百万token,输出24元/百万token。前面两种模式都比DeepSeek-R1性价比更高,后面一种模式DeepSeek模型不支持。除了M1之外,接下来连续四个工作日,我们还准备了一些更新带给大家,敬请期待。