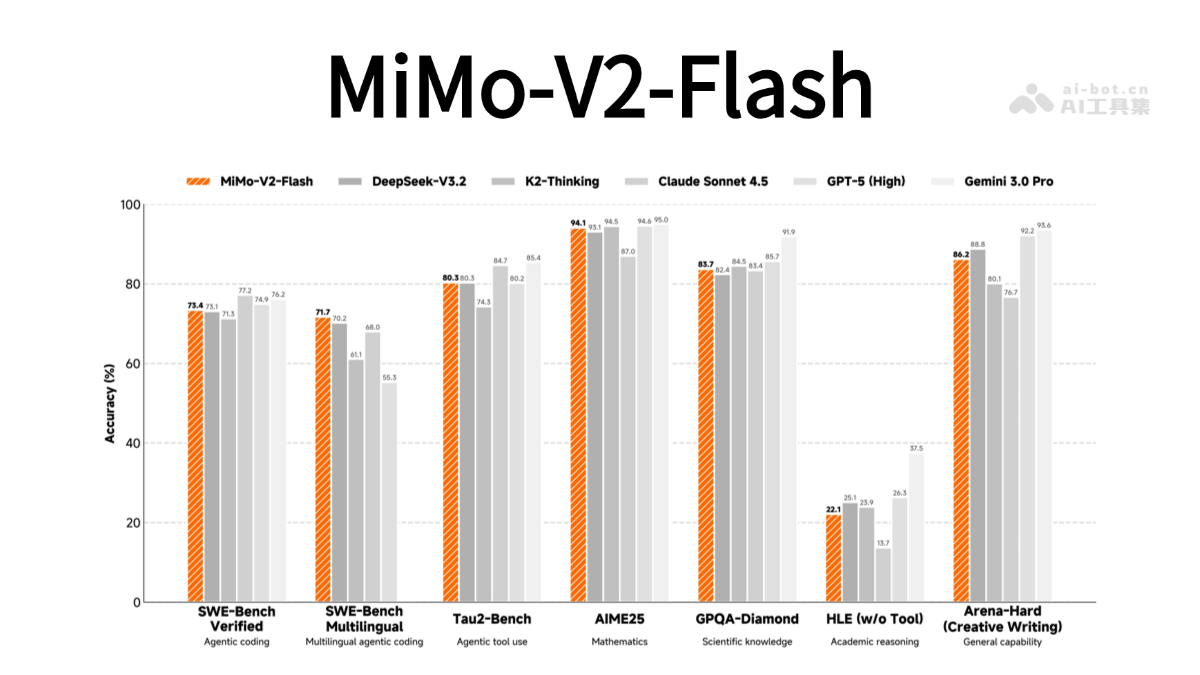

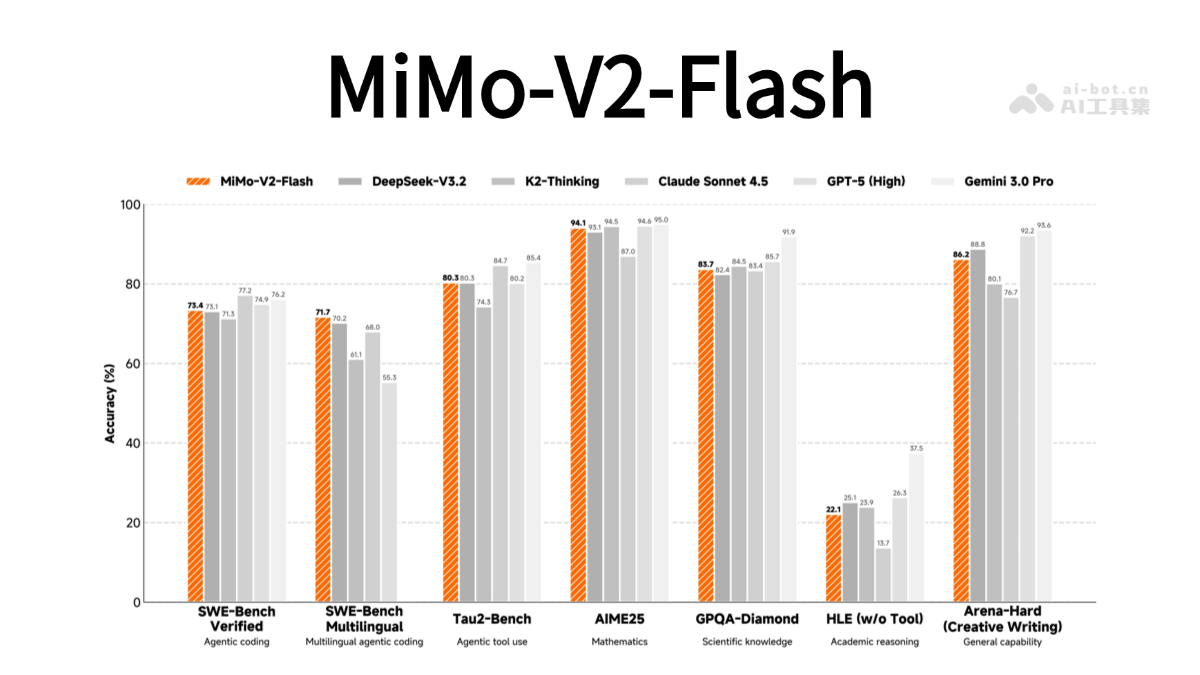

MiMo-V2-Flash-小米开源的高性能语言模型

文章来源:智汇AI 发布时间:2025-12-18

MiMo-V2-Flash 是小米开源的高性能语言模型,具有3090亿总参数和150亿激活参数。专为智能体AI设计,采用混合注意力架构,结合滑动窗口注意力(SW

暂无访问MiMo-V2-Flash是什么

MiMo-V2-Flash 是小米开源的高性能语言模型,具有3090亿总参数和150亿激活参数。专为智能体AI设计,采用混合注意力架构,结合滑动窗口注意力(SWA)和全局注意力(GA),窗口大小为128个token,通过可学习的注意力下沉偏置(sink bias)技术,在保持长文本性能的同时显著降低KV缓存存储量。此外,配备了轻量级多Token预测(MTP)模块,每个模块仅包含0.33亿参数,使用密集前馈网络(FFN)和SWA,能显著提升生成速度,使推理成本仅为标杆闭源模型Claude 4.5 Sonnet的2.5%,生成速度提升2倍。MiMo-V2-Flash 在多个智能体任务和复杂推理任务中表现出色,如SWE-Bench和数学推理任务。支持FP8混合精度推理,推荐使用SGLang框架进行部署。