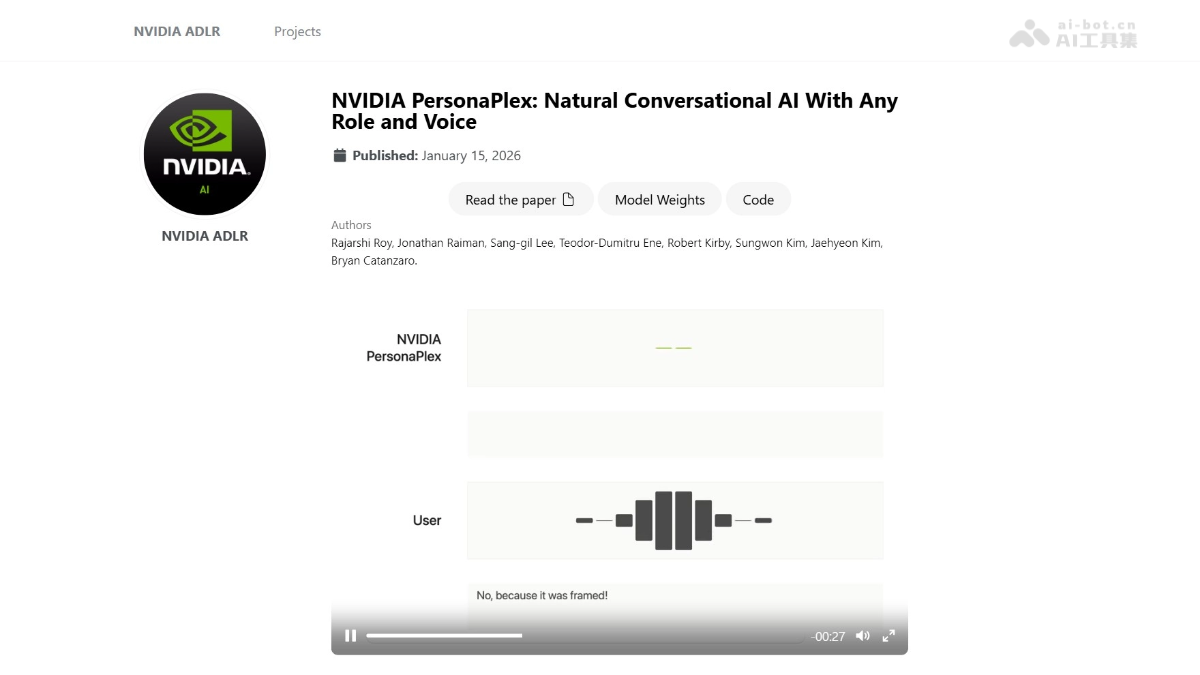

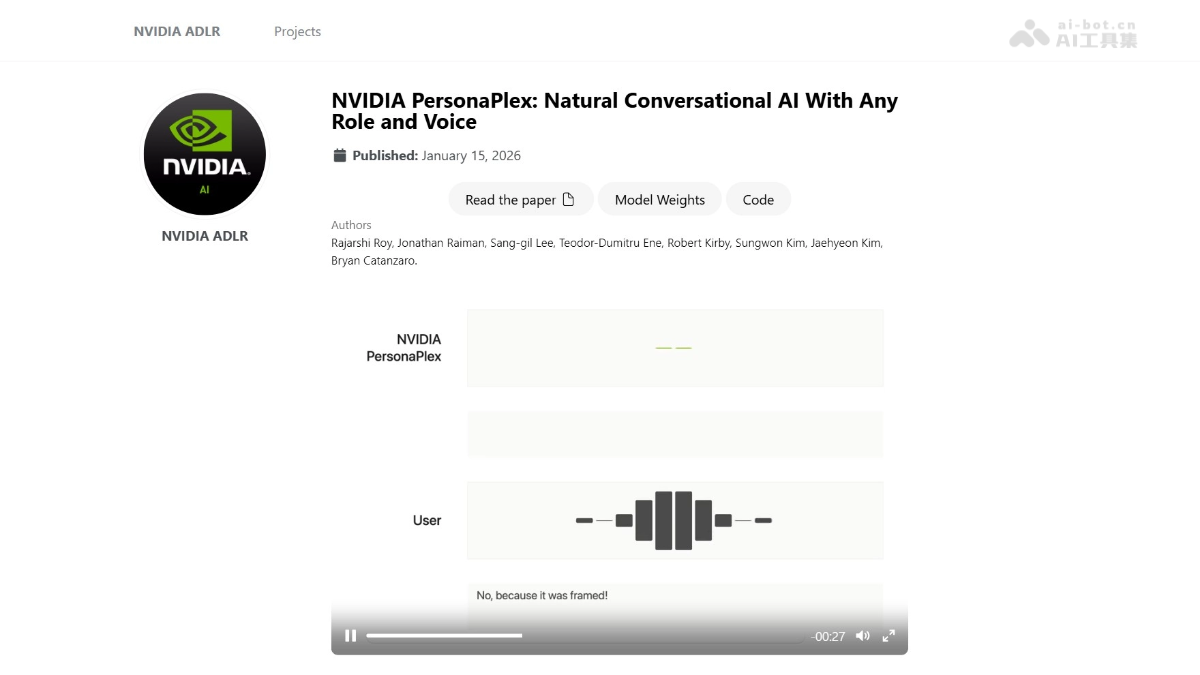

PersonaPlex是什么

NVIDIA PersonaPlex 是英伟达推出的全双工对话AI模型,具备同时听和说的能力,能处理自然对话中的打断、停顿和回应。用户可通过语音和文本提示自定义角色和声音,让 AI 扮演从智慧助手到客服人员的多种角色。模型结合真实对话数据和合成数据进行训练,展现出色的对话自然性和任务遵循能力。PersonaPlex 在多种场景中表现出色,如教育、客服和紧急情况处理,为用户提供真正自然和人性化的交互体验。其中PersonaPlex-7B-v1模型现已开源,供开发者使用。

PersonaPlex的主要功能

全双工对话能力:PersonaPlex能同时听和说,支持实时交互,自然处理对话中的打断、停顿和回应,使对话更加流畅和自然。角色和声音定制:用户可通过文本提示定义角色(如智慧助手、客服人员、虚构角色等),并通过语音提示选择不同的声音风格和语调,实现高度个性化的交互。自然对话行为:支持自然的对话节奏,包括打断、回应(如“嗯哼”、“好的”等)和适当的停顿,让对话感觉更像人类之间的交流。任务遵循能力:支持根据文本提示执行特定任务,如提供客户服务、解答问题或进行技术讨论,在对话中保持一致的角色表现。

PersonaPlex的技术原理

全双工架构:PersonaPlex基于全双工模型,能同时处理用户的语音输入和生成语音输出,避免传统级联系统(ASR→LLM→TTS)的延迟。模型在用户说话的同时更新内部状态,能立即流式传输响应,实现低延迟交互。混合提示架构:语音提示:用音频嵌入(audio embedding)捕捉声音特征、说话风格和韵律。文本提示:通过自然语言描述角色、背景信息和对话上下文。联合处理:语音提示和文本提示联合处理,生成连贯的角色表现。Transformer架构:Mimi语音编码器将音频转换为文本标记(tokens)。Temporal和Depth Transformer能处理对话内容和行为,如何时停顿、何时打断。Mimi语音解码器将文本标记转换为输出语音,支持24kHz的采样率。训练数据:模型用Fisher English语料库中的7303段真实对话(1217小时),通过GPT-OSS-120B生成角色描述。模型用语言模型生成对话脚本,通过Chatterbox TTS合成语音,覆盖多种场景和角色。将真实对话和合成对话结合训练,使模型能学习自然的语音模式和遵循任务要求。

PersonaPlex的项目地址

项目官网:https://research.nvidia.com/labs/adlr/personaplex/GitHub仓库:https://github.com/NVIDIA/personaplexHuggingFace模型库:https://huggingface.co/nvidia/personaplex-7b-v1

PersonaPlex的应用场景

教育领域:作为智慧教师,提供清晰且引人入胜的解答和建议,帮助学生更好地理解知识。