Xiaomi MiMo:小米开源的首个“为推理而生”的大模型

Xiaomi MiMo 是小米公司于 2025 年 4 月 30 日宣布开源的首个为推理而生的ai大模型。MiMo - 7B 系列模型通过充分挖掘语言模型的推理潜力,不仅关注后训练,还注重针对推理的预训练策略。该系列模型在相对较小的 7B 规模下,展现出超越许多 32B 模型的推理能力,其中 MiMo - 7B - RL 在数学和代码推理任务上的表现可与 OpenAI o1 - mini 相媲美。

MiMo核心特点

预训练

数据预处理优化:改进文本提取工具包,采用多维数据过滤,增加预训练数据中的推理模式密度。

合成数据生成:运用多种策略生成大量多样化的合成推理数据。

三阶段数据混合:预训练采用三阶段数据混合策略,MiMo - 7B - Base 在约 25 万亿个标记上进行预训练。

多令牌预测:引入多令牌预测作为额外训练目标,提升模型性能并加速推理。

后训练

优质训练数据:精心挑选 130K 个数学和代码问题作为 RL 训练数据,每个问题都经过仔细清理和难度评估,并使用基于规则的验证器确保数据质量。

代码奖励机制:针对具有挑战性的代码问题,引入测试难度驱动的代码奖励,通过为不同难度的测试用例分配细粒度分数,优化策略。

数据重采样:对简单问题实施数据重采样策略,提高滚动采样效率,稳定策略更新。

RL 基础设施

无缝滚动引擎:开发无缝滚动引擎,集成连续滚动、异步奖励计算和提前终止功能,减少 GPU 空闲时间,使训练速度提高 2.29 倍,验证速度提高 1.96 倍。

MTP 支持:在 vLLM 中支持 MTP,并增强 RL 系统中推理引擎的鲁棒性。

MiMo模型版本

MiMo - 7B - Base:具有卓越推理潜力的基础模型

MiMo - 7B - RL - Zero:从基础模型训练的 RL 模型

MiMo - 7B - SFT:从基础模型训练的 SFT 模型

MiMo - 7B - RL:从 SFT 模型训练的 RL 模型,性能与 OpenAI o1 - mini 相当。

技术细节与创新点

预训练数据优化:通过多维度数据过滤和合成推理数据生成,提升了预训练数据的质量和推理模式密度。

MTP模块:在预训练中引入MTP模块,显著提升了推理任务的性能和推理速度。

RL基础设施:开发了无缝回放引擎(Seamless Rollout Engine),加速了RL训练和验证过程,分别实现了2.29倍和1.96倍的速度提升。

测试难度驱动奖励机制:为解决代码问题中的稀疏奖励问题,提出了基于测试难度的奖励机制,提升了模型在困难问题上的学习效率。

实验与结果

预训练模型性能

MiMo-7B-Base:在多个基准测试中超越了其他7B参数规模的开源模型,如BBH、SuperGPQA等。

推理潜力评估:采用pass@k指标评估模型的推理潜力,MiMo-7B-Base在所有基准测试中均展现出更高的pass@k分数。

后训练模型性能

MiMo-7B-RL-Zero:直接从MiMo-7B-Base进行RL训练,展现了强大的推理能力。

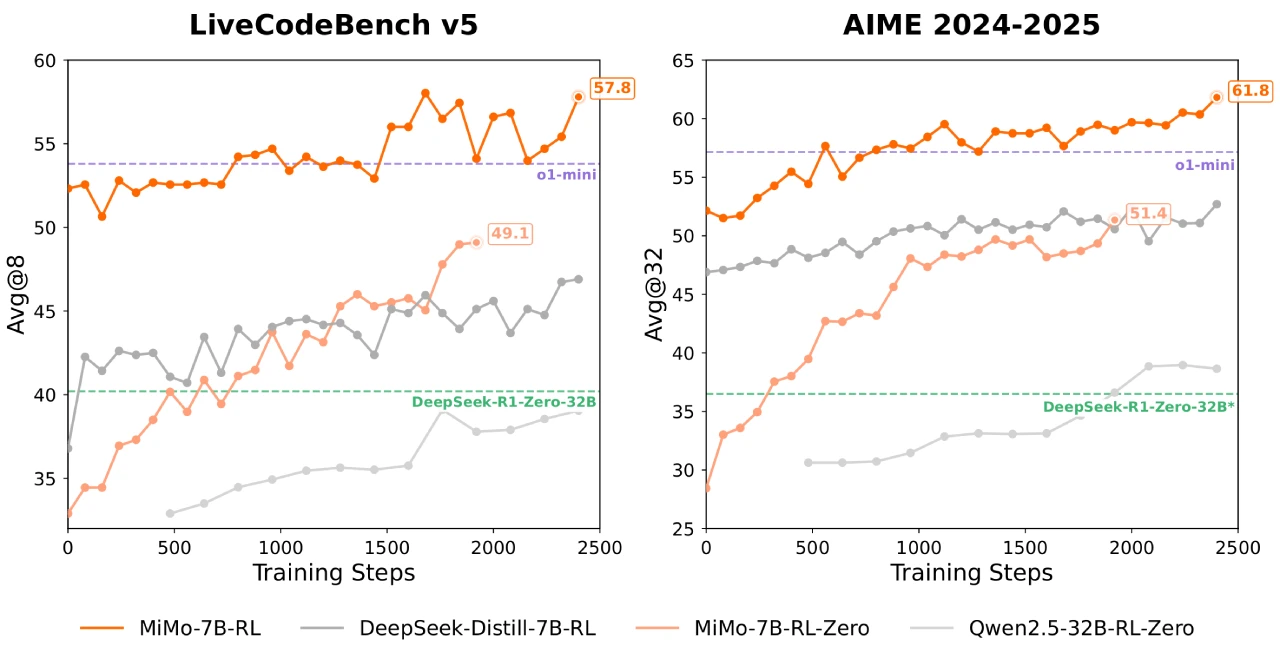

MiMo-7B-RL:从SFT模型进行RL训练,最终在数学和代码任务上超越了OpenAI的o1-mini模型。

具体表现:

在AIME 2025中,MiMo-7B-RL得分55.4,超过o1-mini 4.7分。

在LiveCodeBench v5和v6中,MiMo-7B-RL显著优于o1-mini。

相关链接

Hugging Face平台:https://huggingface.co/XiaomiMiMo

GitHub 仓库:https://github.com/XiaomiMiMo/MiMo

技术报告:https://github.com/XiaomiMiMo/MiMo/blob/main/MiMo-7B-Technical-Report.pdf