智汇AI小编整理的关于Segment Anything Model(SAM)的一些关键更新和里程碑:

一、发布与初始版本

- 发布时间:2023年4月

- 发布机构:Meta AI

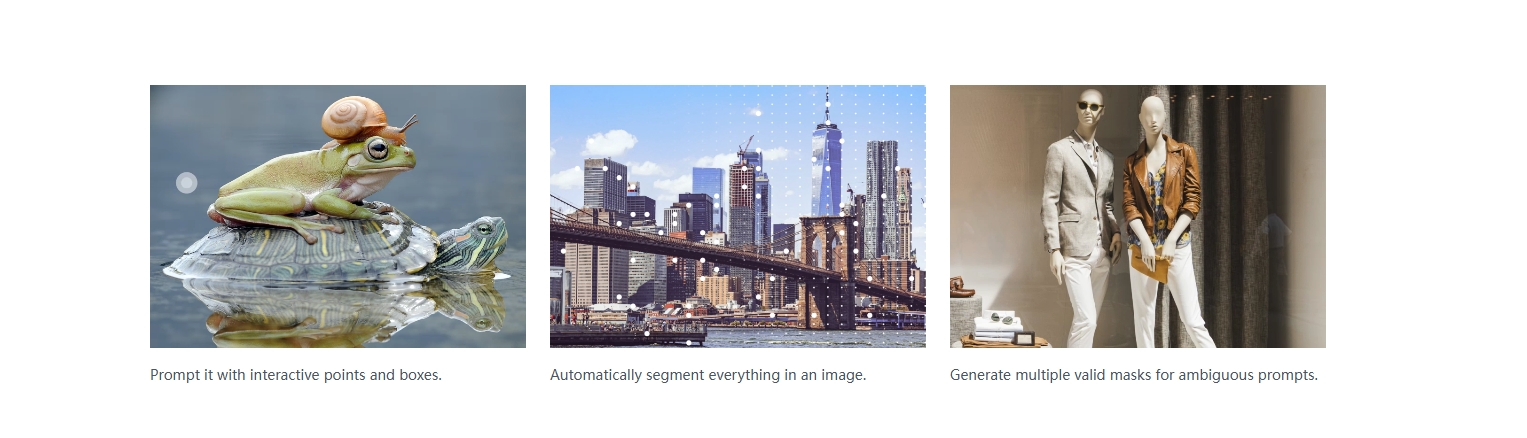

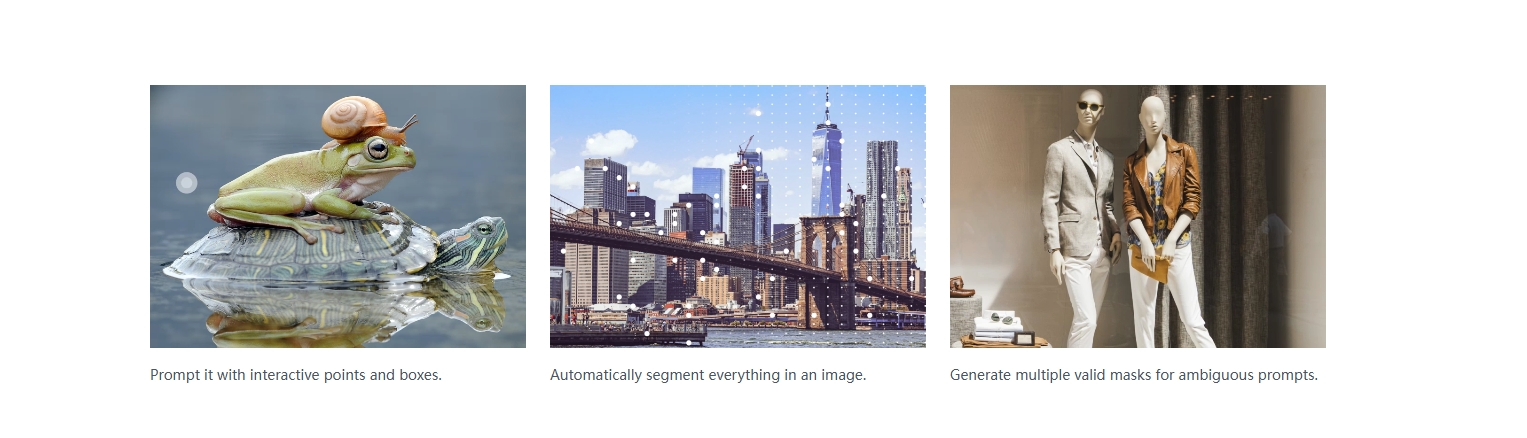

- 核心内容:SAM作为一个强大的图像分割基础模型被发布,它能够对图像中的任何对象进行分割。这一版本的SAM引入了prompt-based交互式分割能力,用户只需提供简单的提示(如点击、框选或文本描述),SAM就能快速准确地分割出相应的对象。

二、数据集与预训练

- SA-1B数据集:为了训练SAM,Meta AI创建了SA-1B数据集,这是当时最大规模的图像分割数据集。该数据集通过高效的数据收集流程构建,包括手工、半自动和全自动三个阶段。

- 预训练:SAM在SA-1B数据集上进行了预训练,使其能够适应各种场景下的分割任务,并展示了强大的泛化能力。

三、模型架构与功能扩展

- 模型架构:SAM由图像编码器、提示编码器和掩码解码器三个部分组成。图像编码器使用ViT(Vision Transformer)结构将输入图像编码为高维特征;提示编码器将用户提供的各种形式的提示(点、框、文本等)编码为向量;掩码解码器结合图像特征和提示信息生成目标对象的分割掩码。

- 功能扩展:随着研究的深入,SAM的功能得到了不断扩展。例如,它被应用于医学图像分析、遥感图像处理、视频处理、3D点云分割和图像修复等多个领域。

四、性能优化与领域适应

- 性能优化:为了提高SAM的分割质量和运行效率,研究者们对其进行了性能优化。例如,通过改进解码器块和动态掩码预测头来优化掩码解码器的性能。

- 领域适应:针对特定领域的需求,研究者们开发了专门的适应版本。例如,面向食品图像的“FoodSAM”等。这些适应版本在特定领域上展示了更好的性能和泛化能力。

五、衍生研究与社区贡献

- 衍生研究:SAM的出现催生了大量的衍生研究。这些研究旨在进一步提升和扩展SAM的能力,如模型轻量化、多模态融合、性能优化和交互式应用等。

- 社区贡献:在GitHub等平台上,研究者们分享了他们的代码、数据集和实验结果,促进了SAM的进一步发展和应用。

六、最新进展与未来方向

- 最新进展:最近的研究表明,SAM在多种下游任务中并非具有很强的鲁棒性与泛化性。为了解决这个问题,研究者们提出了具有锚点正则化和低秩微调的弱监督自训练架构等方法来提高SAM的自适应能力和鲁棒性。

- 未来方向:未来,SAM的研究方向可能包括更轻量级、更高效的模型版本的开发、与其他AI技术的深度融合、在更多垂直领域的深度应用和优化以及基于SAM的新一代计算机视觉开发工具和平台的构建等。

相关文章