LLMs-from-scratch:从零构建大模型

“LLMs-from-scratch” 是一个开源项目,由 Sebastian Raschka 创建,目的是帮助开发者从零开始实现一个类似 ChatGPT 的大型语言模型。这个项目是与他的书籍《Build a Large Language Model (From Scratch)》配套的官方代码仓库。

项目目标

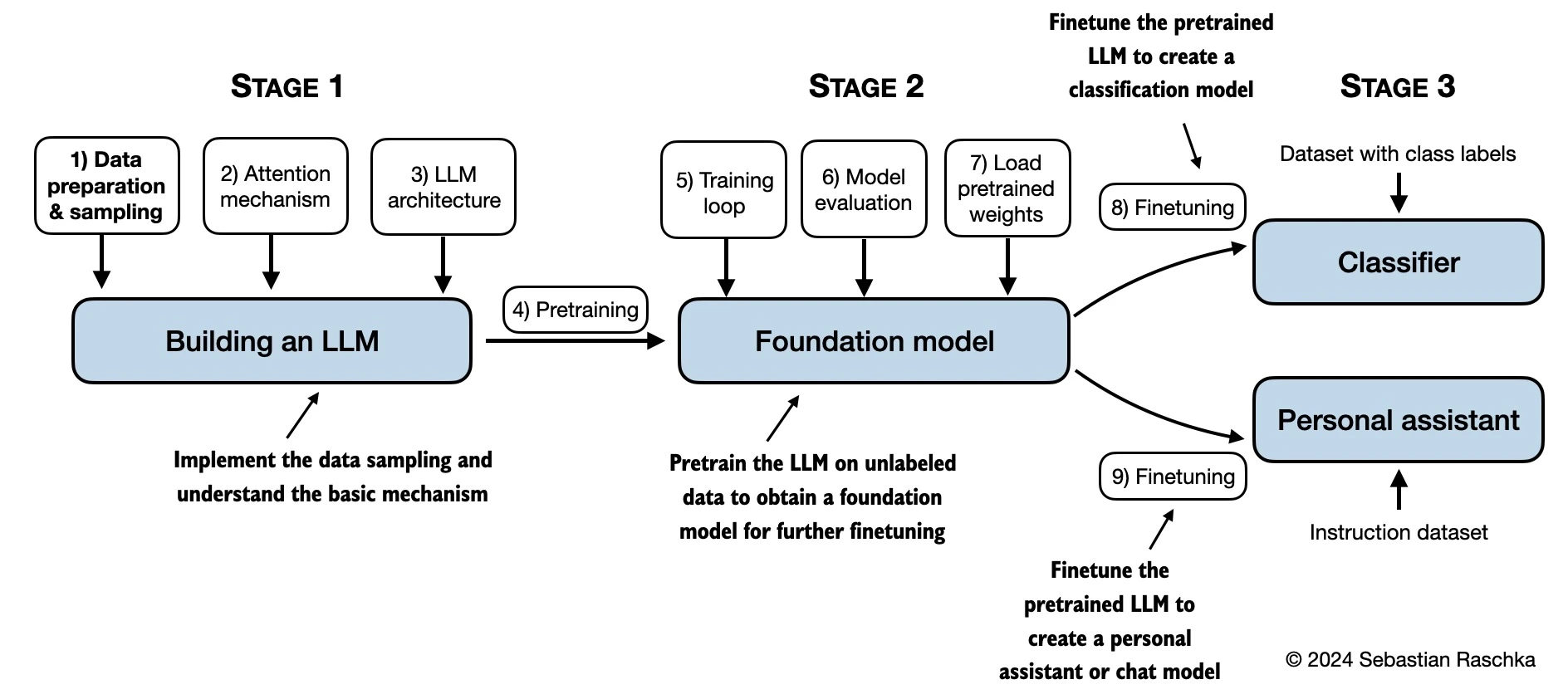

从零开始构建 LLM:通过逐步编码的方式,帮助读者深入理解 LLM 的内部机制。

预训练和微调:提供完整的代码示例,用于在未标记数据上进行预训练,以及针对特定任务进行微调。

教育目的:通过构建小型但功能完备的模型,帮助读者理解大型模型的开发过程。

主要功能结构

第 2 章:处理文本数据

实现从零开始的字节对编码(BPE)分词器。

提供数据加载器的实现和总结。

第 3 章:实现注意力机制

实现多头注意力机制。

第 4 章:从零开始实现 GPT 模型

提供完整的 GPT 模型代码。

第 5 章:在未标记数据上进行预训练

提供预训练代码和生成器代码。

第 6 章:针对文本分类进行微调

提供针对文本分类任务的微调代码。

第 7 章:针对指令跟随进行微调

提供指令微调代码和评估代码。

LLMs-from-scratch适合对自然语言处理和深度学习感兴趣的学习者,尤其是希望从零开始构建大型语言模型的开发者。

英文原版地址:https://github.com/rasbt/LLMs-from-scratch

中文资源地址:https://github.com/MLNLP-World/LLMs-from-scratch-CN